Räumliche Interaktion in einer industriellen Umgebung: Eine Hand steuert ein volumetrisches 3D-Interface, das in Echtzeit auf Bewegung reagiert.

Bild: © Ulrich Buckenlei | VISORIC GmbH 2025

Unsichtbare Interaktion beginnt mit Bewegung

In dem Moment, in dem ein Raum versteht, was ein Mensch tun möchte, bevor er etwas berührt, verändert sich die Logik von Arbeit grundlegend. Systeme, die Bewegungen im Raum als maschinenlesbare Signale interpretieren, reduzieren Reibung, beschleunigen Abläufe und schaffen neue Möglichkeiten für Sicherheit, Qualität und Effizienz. Für Unternehmen bedeutet das: weniger starre Bedienoberflächen, mehr direkte Interaktion mit Maschinen, Anlagen und Informationen – genau dort, wo Entscheidungen entstehen.

Bevor Interfaces sichtbar werden, bevor ein Befehl ausgelöst wird, beginnt ein Prozess, der auf feinen Bewegungen basiert: ein Finger, der sich hebt, eine Hand, die sich dreht, eine subtile Veränderung im Abstand. Diese Mikrogesten bilden die Grundlage eines neuen Interaktionsmodells, das ohne klassische Bildschirme, Schaltflächen oder Geräte funktioniert. Moderne KI-Systeme erkennen diese Bewegungen nicht nur technisch, sondern semantisch. Sie interpretieren, warum sich die Hand so bewegt, welchen Zweck die Geste erfüllt und welche Absicht dahintersteht. Aus einer einfachen Bewegung wird ein strukturiertes Signal – und aus dem Raum ein intelligenter Partner.

Dieses Prinzip bildet die Grundlage vieler neuer Technologien im Bereich Spatial Computing und Motion Intelligence. Um diesen Prozess verständlich zu machen, zeigt die folgende Illustration die wichtigsten Elemente, aus denen unsichtbare Interaktion entsteht.

- Bewegung als Sprache – Mikrogesten werden zu semantischen Signalen, die Systeme direkt verstehen.

- Der Raum als Sensor – die Umgebung erkennt Position, Tiefe und Dynamik von Nutzerinnen und Nutzern.

- Echtzeit-Interpretation – KI verbindet Bewegung mit Intention und löst passende Aktionen aus.

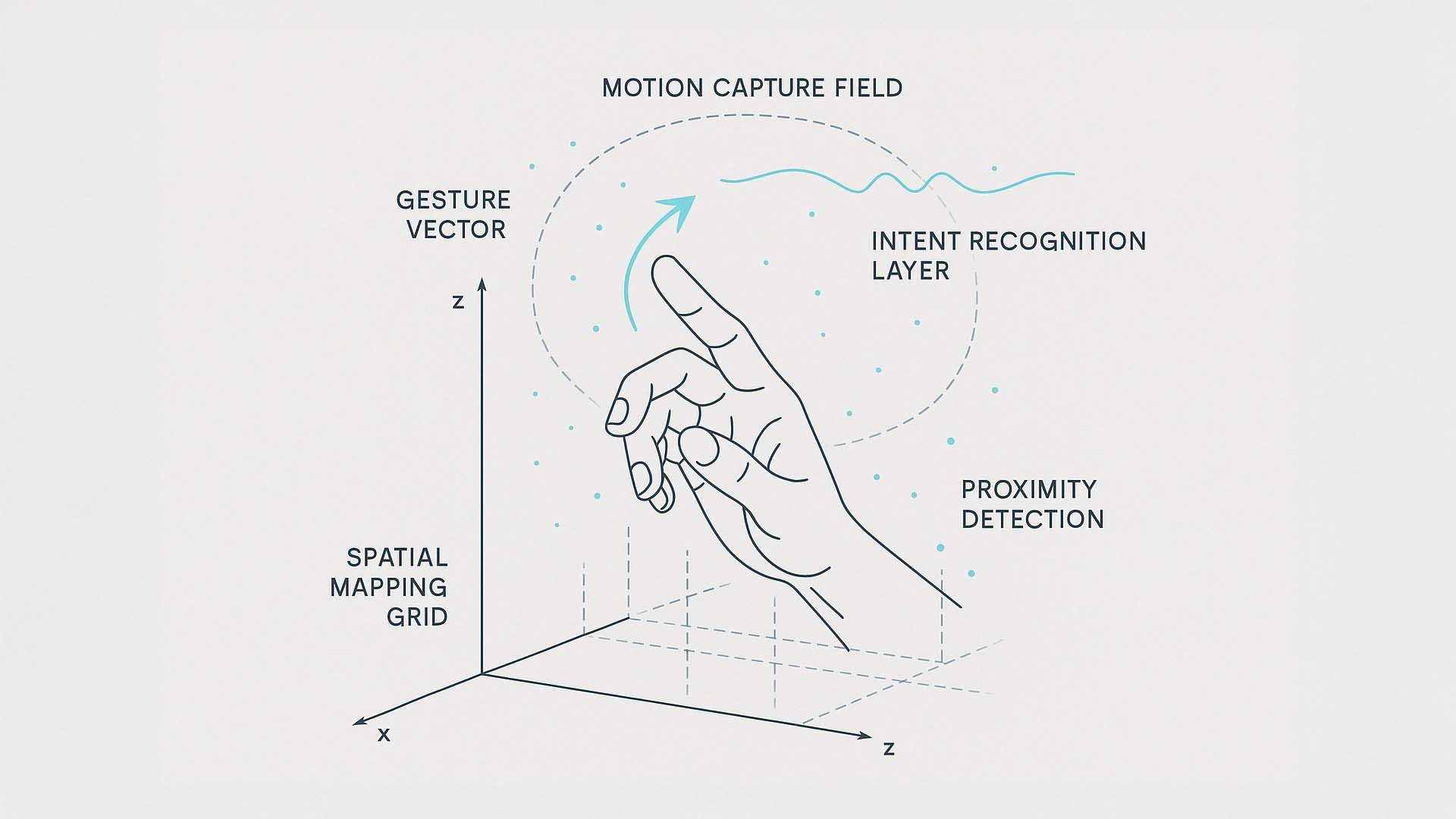

Technische Illustration einer unsichtbaren Interaktion: Die Handbewegung wird in einem räumlichen Koordinatensystem analysiert. Begriffe wie Gesture Vector, Motion Capture Field und Intent Recognition Layer zeigen, wie KI aus Bewegungen verständliche Signale formt.

Bild: © Ulrich Buckenlei | VISORIC GmbH 2025

Die Zeichnung visualisiert, wie ein KI-gestütztes System menschliche Gesten in einem dreidimensionalen Raum analysiert und interpretiert. Der Gesture Vector zeigt Richtung und Dynamik der Geste; das Motion Capture Field beschreibt das volumetrische Feld, in dem Bewegungen erfasst werden. Im Intent Recognition Layer übersetzt die KI diese Daten in Bedeutung, erkennt Muster und Absichten. Proximity Detection steuert, wie stark ein Element auf die Annäherung der Hand reagiert, während das Spatial Mapping Grid die räumliche Einordnung übernimmt. Erst das Zusammenspiel dieser Ebenen macht den Raum zu einem System, das Verhalten versteht und in Echtzeit darauf reagieren kann.

Im nächsten Abschnitt rücken wir einen Schritt näher an die Praxis heran und betrachten, wie sich aus diesen Grundlagen konkrete Interaktionsmodelle entwickeln, in denen Geste, Tiefe, Raumverlauf und KI-Interpretation zu einem einzigen, fließenden Bewegungsstrom werden.

Wie Bewegung, Tiefe und Raumlogik zu einem Interaktionsmodell verschmelzen

Bewegungen im Raum bestehen nicht aus einer einzigen Komponente. Erst wenn Geste, Geschwindigkeit, Tiefe, Position und räumlicher Verlauf gemeinsam erfasst und interpretiert werden, entsteht ein Bewegungsstrom, der für KI-Systeme lesbar ist. In modernen Spatial-Computing-Umgebungen erkennt die Technologie nicht nur, wohin sich eine Hand bewegt, sondern auch, wie schnell, wie tief, in welchem Muster und mit welcher Wahrscheinlichkeit eine bestimmte Aktion beabsichtigt ist. Genau aus dieser Kombination entsteht ein Interaktionsmodell, das sich nicht mehr wie eine Bedienung anfühlt, sondern wie ein natürlicher Bewegungsfluss.

Um diese Logik sichtbar zu machen, zeigt die folgende Visualisierung, wie mehrere Schichten gleichzeitig zusammenwirken. Sie verbindet physische Geste, Datenfelder, Musteranalyse und Bewegungsprognose zu einem einzigen, dynamischen AI-Flow. Das Bild macht sichtbar, wie KI aus einer scheinbar einfachen Fingerbewegung ein mehrdimensionales Steuerungssignal erzeugt.

- Mehrdimensionale Erfassung – Geste, Tiefe, Geschwindigkeit und Verlauf wirken zusammen.

- Datenbasierte Interpretation – KI erkennt Muster und Wahrscheinlichkeiten.

- Fließender Bewegungsstrom – mehrere Ebenen verschmelzen zu einem Interaktionsmodell.

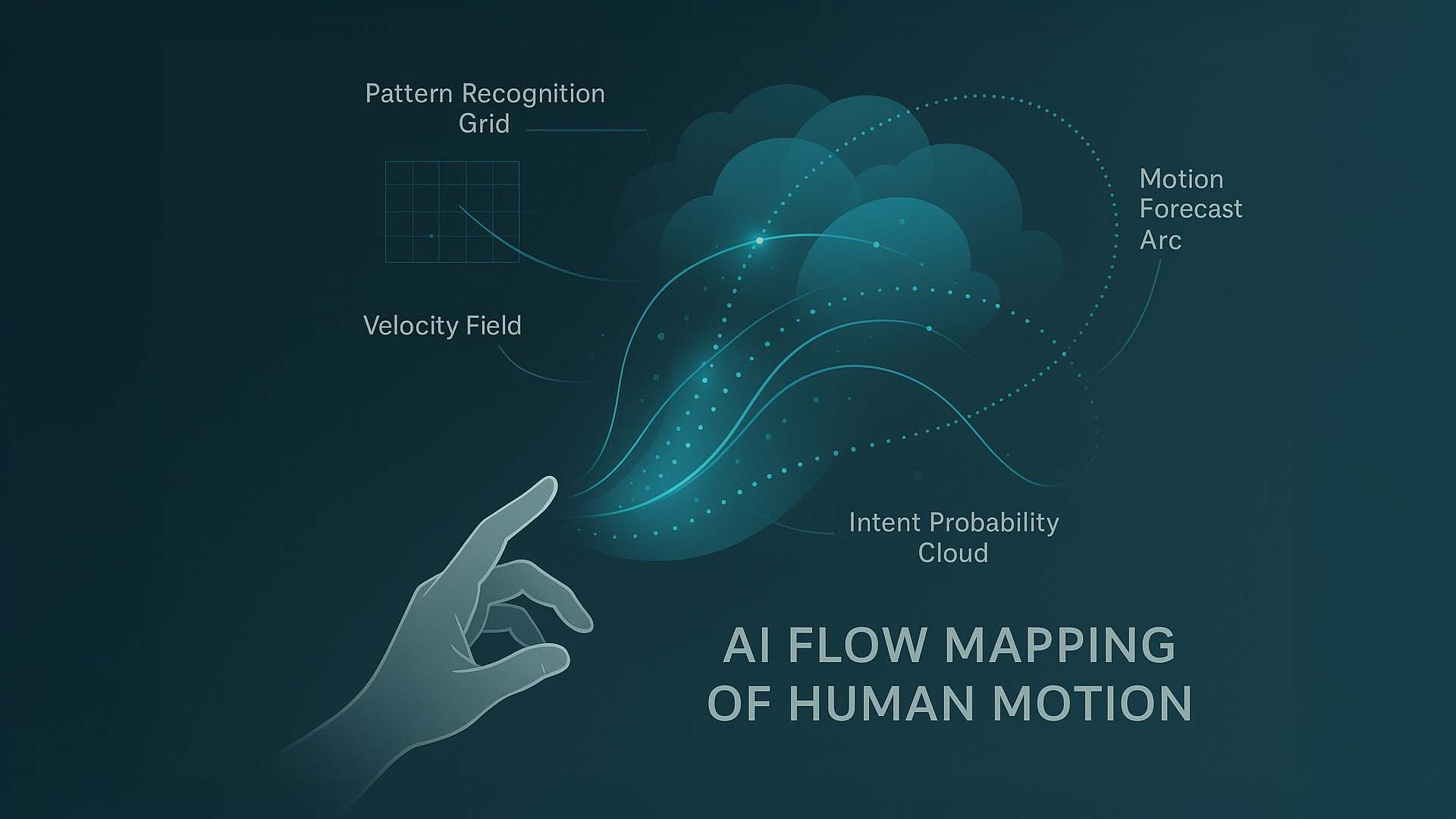

AI Flow Mapping of Human Motion: Die Visualisierung zeigt, wie KI Bewegungsdaten gleichzeitig in Muster, Geschwindigkeit, räumliche Tiefe und Prognosen zerlegt. Begriffe wie „Pattern Recognition Grid“, „Velocity Field“, „Intent Probability Cloud“ und „Motion Forecast Arc“ machen sichtbar, wie aus einer einzelnen Geste ein fließender Bewegungsstrom entsteht.

Bild: © Ulrich Buckenlei | VISORIC GmbH 2025

Das Bild zeigt eine Hand unten links, deren Fingerbewegung als Ausgangspunkt dient. Über der Hand entfaltet sich ein technisch-ästhetischer Datenstrom aus Lichtbahnen, Punkten und semitransparenten Ebenen. Jede dieser Ebenen repräsentiert einen Baustein der KI-Analyse:

Pattern Recognition Grid – ein Gitterfeld, das die Bewegungsform als Muster erkennt und mit bekannten Interaktionsabläufen vergleicht.

Velocity Field – ein Datenfeld, das Geschwindigkeit und Beschleunigung der Bewegung misst und daraus Bedeutung ableitet.

Intent Probability Cloud – eine semitransparente „Wahrscheinlichkeitswolke“, in der die KI berechnet, welche Aktion die Hand höchstwahrscheinlich auslösen möchte.

Motion Forecast Arc – eine prognostizierte Bewegungskurve, die zeigt, wie sich die Hand in den nächsten Millisekunden weiterbewegen wird.

Die Visualisierung verdeutlicht, dass moderne Interaktionssysteme nicht auf eine einzelne Bewegung reagieren, sondern auf einen gesamten Kontext. Aus vielen Datenpunkten entsteht ein durchgehender Bewegungsstrom, der für Menschen intuitiv bleibt, für Maschinen jedoch präzise lesbar wird. Im nächsten Abschnitt betrachten wir, wie diese Interaktionslogiken in realen Umgebungen – etwa in Offices, Werkhallen oder Trainingssystemen – konkrete Gestaltungsmöglichkeiten eröffnen.

Wie Interaktionslogiken reale Räume verwandeln

Wenn Bewegung, Tiefe, Raumzonen und KI-Interpretation zusammenwirken, entsteht eine neue Form von Arbeitsumgebung: Räume, die verstehen, was Menschen tun wollen, noch bevor ein klassisches Interface sichtbar wird. Die folgenden Beispiele zeigen, wie solche Interaktionslogiken bereits heute in Büros, Produktionsbereichen oder Trainingsumgebungen genutzt werden können. Statt starrer Bedienelemente entstehen kontextabhängige Informationsschichten, die sich dynamisch an den Ort, die Aufgabe und die Bewegung einer Person anpassen.

Moderne Systeme interpretieren Blickrichtung, Position, Entfernung und Bewegungsmuster in Echtzeit. Dadurch entsteht ein Arbeitsraum, der Informationen dorthin legt, wo sie gebraucht werden, statt Menschen zu zwingen, Werkzeuge oder Displays zu suchen. Diese Entwicklung führt zu effizienteren Entscheidungen, einer natürlicheren Bedienlogik und einer Umgebung, die mitdenkt.

- Raum als Informationsarchitektur – Inhalte erscheinen dort, wo die Aufgabe entsteht.

- Kontextabhängige Einblendungen – Maschinen, Objekte und Arbeitsplätze erzeugen dynamische Overlays.

- Bewegungsgesteuerte Priorisierung – der Raum erkennt Relevanz durch Nähe, Blick und Handlung.

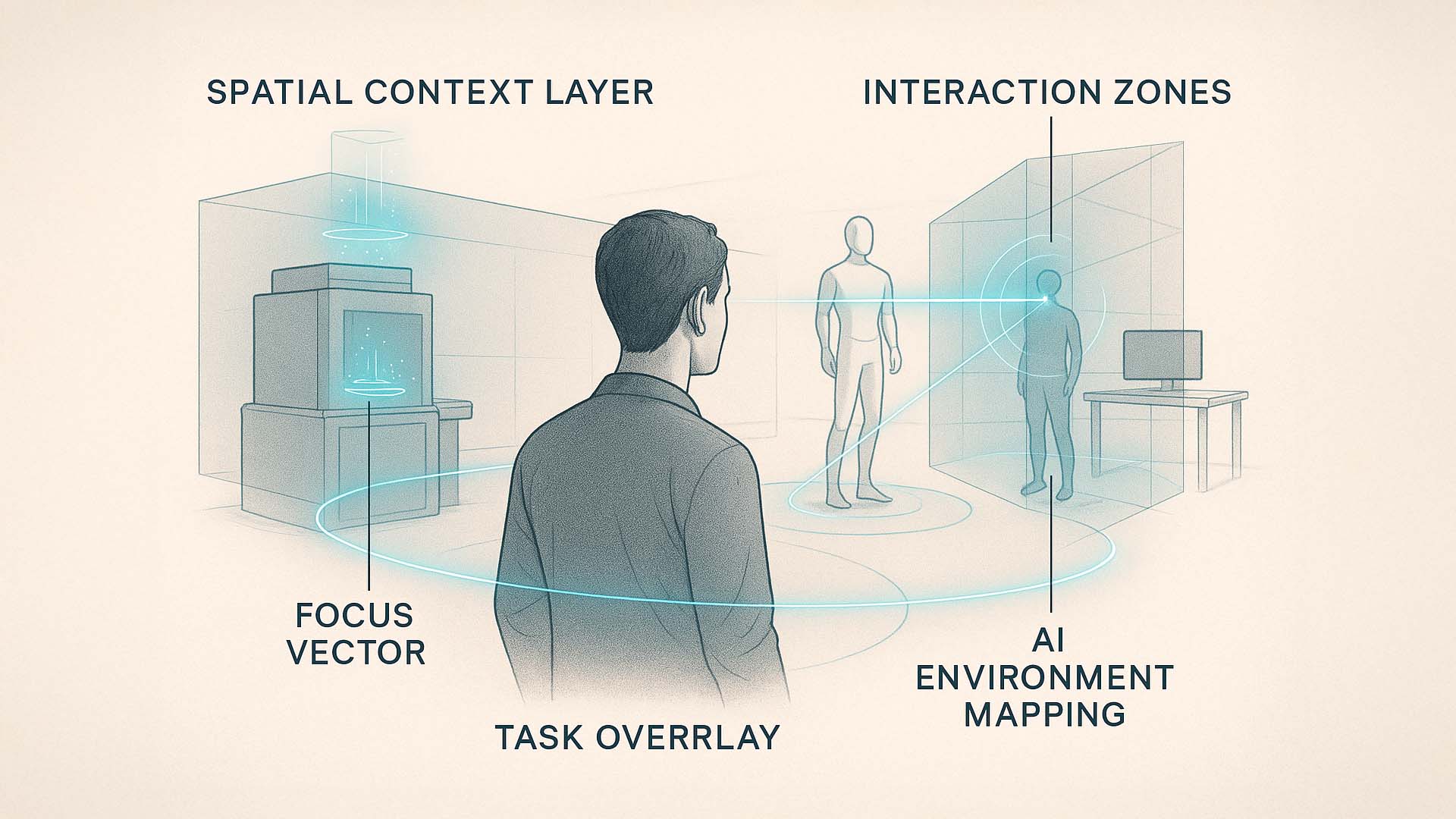

Context-Aware Spatial Workspace: Die Illustration zeigt, wie KI den realen Raum interpretiert und daraus Interaktionsbereiche erzeugt. Elemente wie „Spatial Context Layer“, „Interaction Zones“, „Task Overlay“, „Focus Vector“ und „AI Environment Mapping“ machen sichtbar, wie Räume beginnen, Verhalten zu verstehen.

Bild: © Ulrich Buckenlei | VISORIC GmbH 2025

Im Bild sehen wir einen Nutzer in einer realen Umgebung – eine Mischung aus Arbeits- und Interaktionsraum. Um ihn herum entstehen mehrere technische Ebenen, die zeigen, wie KI den Kontext der Situation analysiert. Der Spatial Context Layer bildet eine semitransparente räumliche Ebene, die Auskunft darüber gibt, welche Bereiche des Raums aktuell relevant sind. Die Interaction Zones markieren Bereiche, in denen Bewegungen oder Gesten besondere Bedeutung erhalten. Über einem Objekt erscheint ein Task Overlay, ein kleines Datenfeld, das kontextabhängige Informationen einblendet – beispielsweise Hinweise zu Bedienung, Status oder Sicherheit.

Der Focus Vector verbindet den Blick oder die Orientierung des Nutzers mit einem bestimmten Objekt. Dies zeigt, wie die KI erkennt, worauf sich die Aufmerksamkeit richtet. Ergänzend dazu visualisiert das AI Environment Mapping die Fähigkeit des Systems, die Umgebung zu scannen, zu verstehen und daraus Prognosen abzuleiten. Dadurch entsteht eine Arbeitswelt, die nicht reagiert, sondern antizipiert.

Diese Szene zeigt beispielhaft, wie Räume zu aktiven Informationspartnern werden. Statt passiv auf Eingaben zu warten, unterstützen sie den Menschen durch kontextuelles Denken – sichtbar gemacht durch die leuchtenden Linien und dynamischen Ebenen im Raum. Die Interaktion wird dadurch flüssiger, natürlicher und effizienter. Im nächsten Abschnitt betrachten wir, wie solche Systeme durch adaptive KI-Schichten noch präziser und intelligenter werden und wie sie selbst komplexe Arbeitsprozesse vorausschauend unterstützen können.

Wie adaptive KI-Schichten Interaktionen präziser und vorausschauender machen

Bevor ein räumliches Interaktionssystem überhaupt reagieren kann, müssen viele unsichtbare Schritte im Hintergrund ablaufen. Jede Geste, jede Bewegung, jedes räumliche Signal wird von einer mehrschichtigen KI verarbeitet, die Muster erkennt, Kontext einordnet und zukünftige Aktionen antizipiert. Diese Schichtung ist das eigentliche Herz der nächsten Generation von Spatial Computing – und entscheidet darüber, ob Interaktionen nur funktionieren oder sich tatsächlich natürlich anfühlen.

Die neu erstellte Visualisierung zeigt diesen unsichtbaren Prozess erstmals klar und verständlich. Sie macht sichtbar, wie sich mehrere KI-Ebenen übereinanderlegen und aus rohen Sensordaten ein sinnvolles, intelligentes und vorausschauendes Interaktionsverhalten entsteht. Jede Ebene erfüllt dabei eine eigene Funktion – und gemeinsam erzeugen sie eine Art “digitales Nervensystem”, das unser Verhalten im Raum nicht nur erkennt, sondern versteht.

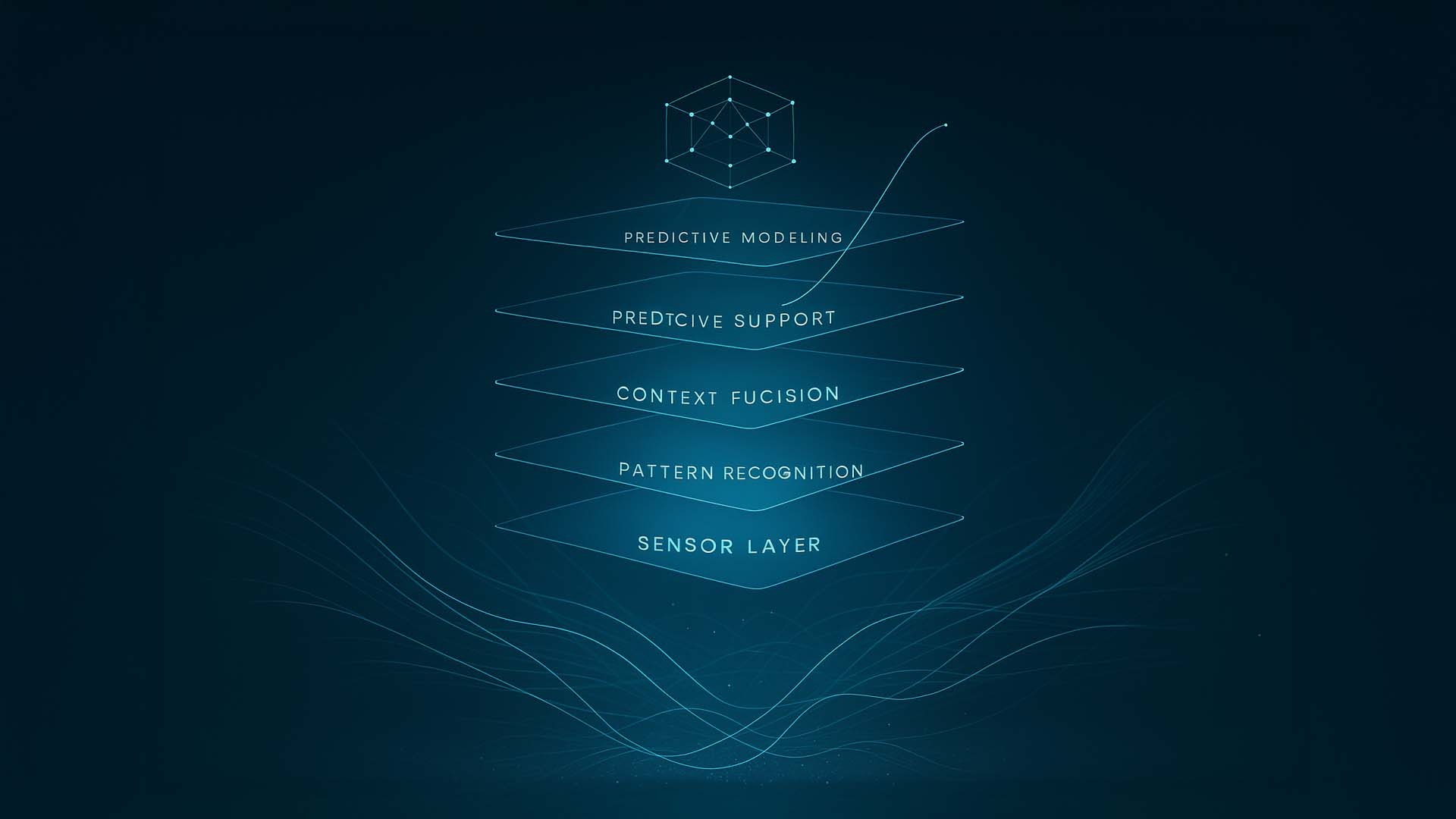

- Sensor Layer → Die unterste Ebene sammelt Rohdaten: Positionspunkte, Bewegungskurven, Tiefe und Geschwindigkeit. Hier entsteht das Grundmaterial, aus dem alle weiteren Interpretationen aufgebaut werden.

- Pattern Recognition → Diese Schicht erkennt wiederkehrende Muster in der Bewegung: typische Gesten, Abläufe, Richtungswechsel und Mikroreaktionen. Aus chaotischen Daten wird eine erkennbare Struktur.

- Context Fusion → Die dritte Ebene kombiniert Bewegungsdaten mit räumlichem Umfeld, Aufgabe und Situation. Die KI versteht: Wo findet die Interaktion statt, welcher Kontext ist relevant, welche Bedeutungen ergeben sich?

- Predictive Modeling → Hier beginnt die Vorausschau. Die KI errechnet, welche Bewegungen wahrscheinlich folgen, welche Ziele der Nutzer verfolgt und welche Optionen sinnvoll sind. Aus Verhalten wird Erwartung.

- Predictive Support → Die oberste Ebene wandelt diese Einschätzung in konkrete Unterstützung um. Interfaces passen ihre Position an, wichtige Optionen rücken näher, Reaktionen werden beschleunigt oder bereits vorbereitet.

Adaptive AI Layer Stack: Die Visualisierung zeigt fünf KI-Schichten – von der Sensordatenerfassung bis zur vorausschauenden Entscheidungsunterstützung.

Visualisierung: © Ulrich Buckenlei | Visoric GmbH, 2025

Im Bild werden die Schichten als schwebende, semitransparente Ebenen dargestellt – jede klar voneinander getrennt und dennoch Teil eines zusammenhängenden Prozesses. Am unteren Rand formen fließende Bewegungslinien die Rohdaten, aus denen die KI liest. Darüber folgen die Ebenen der Interpretation: Mustererkennung, Kontextfusion und prädiktive Modelle. Ganz oben schwebt die Schicht Predictive Support, die sichtbar macht, wie das System dem Menschen künftig einen Schritt voraus sein kann – ohne Dominanz, sondern als intelligente Unterstützung.

Diese Darstellung zeigt exemplarisch, wie moderne räumliche Systeme nicht nur reagieren, sondern agieren. Je mehr die KI versteht, desto weniger muss der Mensch bewusst steuern. Systeme beginnen, Bedürfnisse zu antizipieren, Abläufe vorzustrukturieren und komplexe Aufgaben durch intelligente Vorauswahl zu vereinfachen. Damit entsteht ein Arbeitsmodus, in dem Interaktionen nicht nur schneller, sondern auch mental deutlich leichter werden.

Im nächsten Abschnitt betrachten wir, wie diese vorausschauenden KI-Modelle nicht nur einzelne Gesten erleichtern, sondern ganze Arbeitsprozesse unterstützen – von industriellen Abläufen bis zu Trainingsumgebungen, in denen das System Fehler erkennt, bevor sie entstehen.

Wie KI ganze Arbeitsprozesse vorausschauend unterstützt

Während adaptive KI-Schichten einzelne Bewegungen und Gesten präzise interpretieren können, entfaltet sich ihr größtes Potenzial erst auf der Ebene kompletter Arbeitsprozesse. Moderne Systeme analysieren nicht mehr nur Momentaufnahmen, sondern verstehen Abläufe im Zusammenhang: Welche Schritte folgen aufeinander, wo entstehen Risiken, wann ist Unterstützung nötig und wie lassen sich Aufgaben beschleunigen, ohne die Sicherheit oder Qualität zu beeinträchtigen?

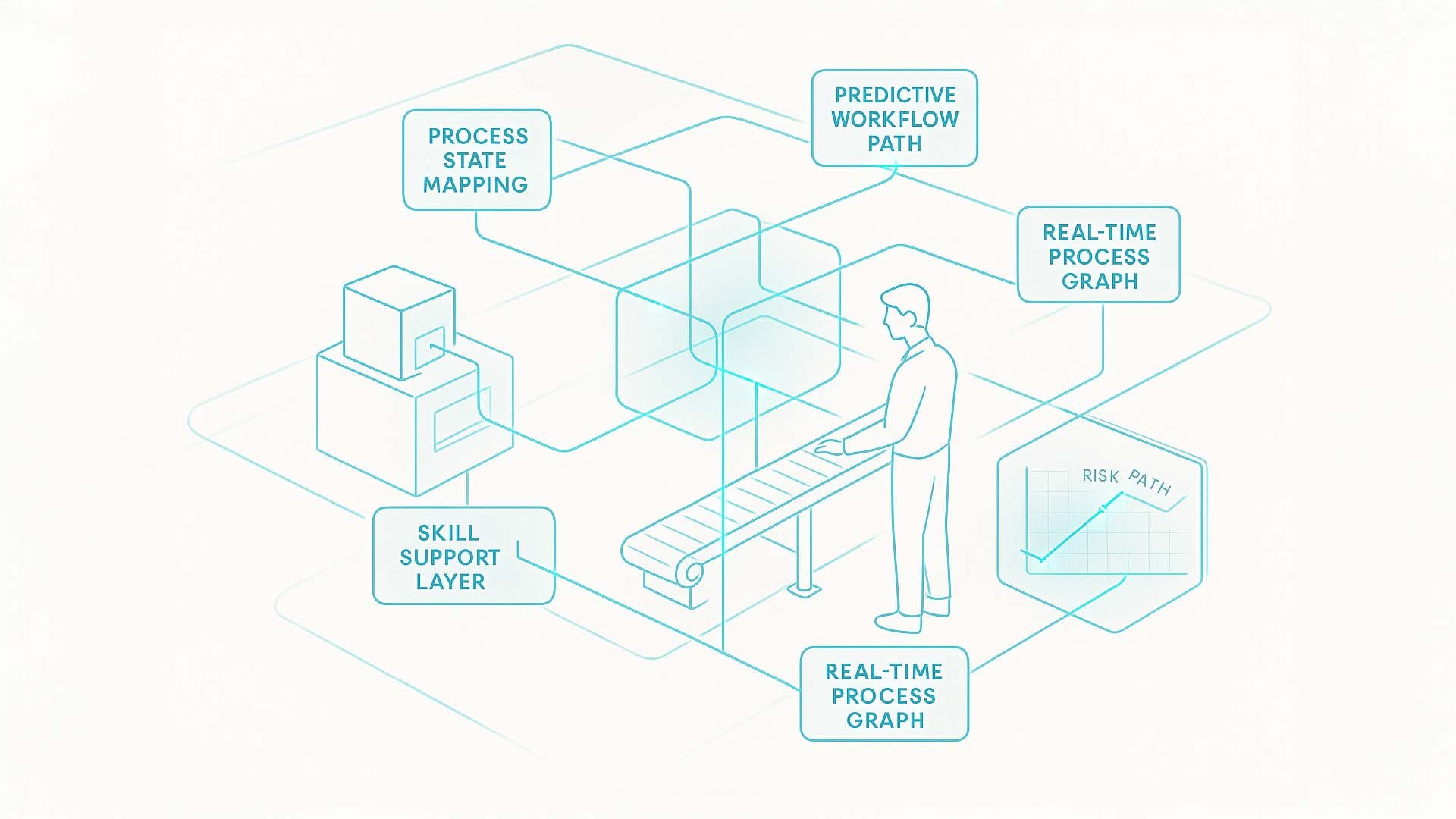

Die neue technische Illustration zeigt genau diesen erweiterten Blick. Sie bildet eine vereinfachte Produktions- oder Trainingsumgebung ab und macht sichtbar, wie künstliche Intelligenz räumliche Abläufe versteht, verknüpft und vorausschauend steuert. Der Mensch, die Maschine, der Materialfluss – alles wird Teil eines integrierten Informationssystems, das Muster erkennt, Entwicklungen prognostiziert und situativ eingreift, bevor Fehler entstehen.

- Process State Mapping → Die KI erfasst kontinuierlich den aktuellen Zustand eines Systems: Welche Maschine läuft, welcher Schritt ist aktiv, welche Parameter verändern sich.

- Predictive Workflow Path → Aus dem erkannten Zustand wird abgeleitet, welche Arbeitsschritte als Nächstes folgen – inklusive alternativer Pfade.

- Anomaly Forecast → Die KI analysiert Abweichungen im Verhalten und kann potenzielle Fehler schon erkennen, bevor sie real auftreten.

- Skill Support Layer → Assistenzebene, die abhängig von Erfahrung und Können einer Person Hinweise, Empfehlungen oder stabilisierende Informationen einblendet.

- Real-Time Process Graph → Eine visuelle Darstellung des kompletten Prozessmodells, das in Echtzeit reagiert und sich bei jeder Bewegung aktualisiert.

Predictive Process Intelligence: Die Illustration zeigt, wie KI ganze Arbeitsprozesse analysiert, prognostiziert und optimiert – von Prozesszuständen über Workflow-Pfade bis zur Fehlererkennung in Echtzeit.

Visualisierung: © Ulrich Buckenlei | Visoric GmbH, 2025

In der Darstellung sehen wir eine abstrahierte Produktionsszene: ein Mensch steht an einem Förderband, rechts und links befinden sich Maschinenmodule, die Daten in die KI-Schichten einspeisen. Über und zwischen den Objekten schweben feine Linien und transparente Informationsrahmen, die verdeutlichen, wie künstliche Intelligenz unterschiedliche Quellen miteinander verknüpft. Begriffe wie Process State Mapping und Real-Time Process Graph symbolisieren die Logik, mit der das System den aktuellen Zustand versteht. Begriffe wie Predictive Workflow Path oder Anomaly Forecast zeigen die nächste Stufe: die Fähigkeit, auf Basis von Datenflüssen mögliche Entwicklungen vorherzusehen.

Die Szene macht deutlich, wie KI zunehmend nicht mehr nur reagiert, sondern agiert. Sie erkennt Muster, bevor sie sichtbar werden. Sie zeigt Risiken an, bevor sie kritisch werden. Und sie unterstützt Menschen, bevor Überforderung entsteht. Damit wird die Interaktion nicht nur sicherer, sondern tiefgreifend intelligenter – ein entscheidender Schritt in der Evolution von industriellen und kreativen Prozessen.

Im nächsten Abschnitt betrachten wir, wie diese vorausschauenden Systeme in komplexen Arbeitsumgebungen konkrete Vorteile schaffen: effizientere Entscheidungen, geringere Fehlerquoten und eine neue Art der Zusammenarbeit zwischen Mensch, Raum und künstlicher Intelligenz.

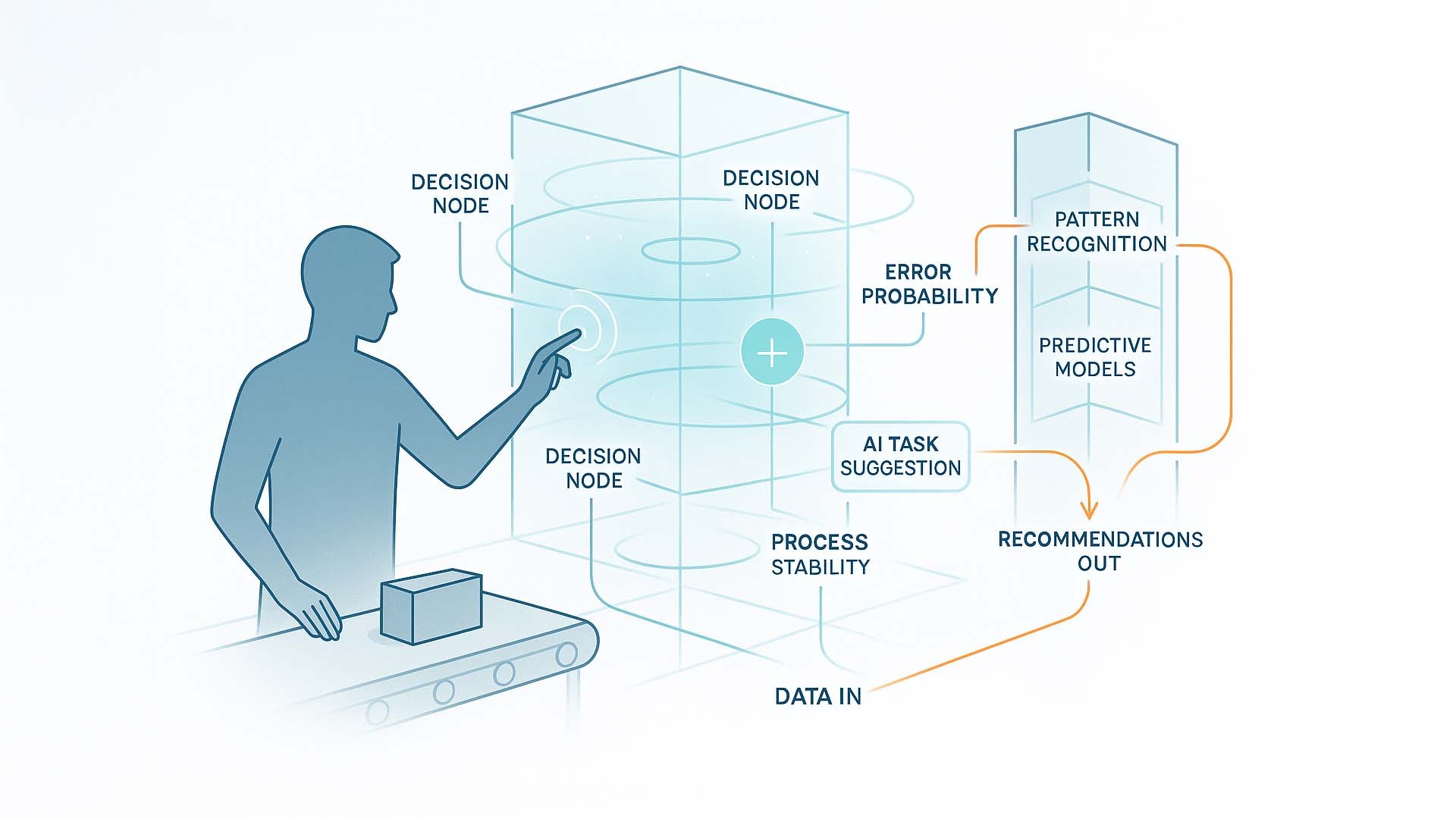

Wenn KI den Arbeitsraum mitdenkt

Digitale Interaktionen werden erst dann wirklich leistungsfähig, wenn künstliche Intelligenz nicht nur auf Gesten reagiert, sondern aktiv den Kontext versteht, Muster erkennt und Handlungsschritte vorausdenkt. Das neu erstellte Visual zeigt genau diesen Übergang: von reiner Bewegungssteuerung hin zu einem System, das menschliches Verhalten, räumliche Abläufe und maschinelle Prozessdaten zu einem einzigen, intelligenten Entscheidungsstrom verbindet.

In der dargestellten Szene arbeitet eine Person an einem Förderband. Über der Arbeitsfläche schwebt ein volumetrisches Interface, das mehrere Entscheidungspunkte definiert. Diese sogenannten Decision Nodes fungieren als räumliche Markierungen, an denen das System versteht, dass eine bestimmte Handlung bevorsteht – etwa das Prüfen eines Objekts oder das Auslösen eines Prozessschritts.

- Decision Nodes → Schnittpunkte, an denen das System menschliche Handlungspfade erkennt

- Error Probability → Schätzt das Fehlerrisiko des aktuellen Arbeitsschritts

- AI Task Suggestion → KI-Vorschläge für den nächsten sinnvollen Schritt

- Process Stability → Bewertung der gesamten Prozesslage in Echtzeit

- Data In → Sensordaten, Bewegungsmuster und Kontextinformationen fließen ein

- Pattern Recognition → Erkennung von Mustern im Verhalten, Objektzustand oder Prozessverlauf

- Predictive Models → KI prognostiziert wahrscheinliche Abläufe und Auswirkungen

- Recommendations Out → Das System gibt konkrete Handlungsempfehlungen zurück

Das Zusammenspiel aus räumlicher Interaktion und KI: Der Arbeitsraum wird zum kognitiven Partner des Menschen.

Visualisierung: © Ulrich Buckenlei | VISORIC GmbH 2025

Die Grafik verdeutlicht, wie der Arbeitsraum selbst zu einer intelligenten Entscheidungsoberfläche wird. Jede Bewegung der Hand verändert den Status des Systems, jedes Objekt liefert Datenpunkte, und jedes Variation im Ablauf erzeugt neue Muster, die von den Pattern Recognition-Modellen interpretiert werden. Die Predictive Models rechnen in Echtzeit durch, welche Folgen eine Entscheidung haben könnte – von Qualitätsabweichungen bis zu potenziellen Prozessfehlern.

Besonders zentral ist der Mechanismus der Error Probability. Dieser kreisförmige Layer im Interface zeigt an, wie hoch die Wahrscheinlichkeit ist, dass der aktuelle Arbeitsschritt zu einer Abweichung führen könnte. Wird ein Grenzwert erreicht, aktiviert sich automatisch die AI Task Suggestion: Das System schlägt vor, was als Nächstes getan werden sollte, um Stabilität zu sichern.

Die gesamte Arbeitsumgebung arbeitet damit nicht mehr wie ein passives Werkzeug, sondern wie ein intelligenter Partner. Der Mensch entscheidet weiterhin – aber mit einer KI, die Risiken erkennt, bevor sie entstehen, und Abläufe vorausschauend optimiert. Das Ergebnis ist ein messbarer Vorteil in komplexen Produktions-, Service- oder Trainingsszenarien: weniger Fehler, schnellere Entscheidungen und eine deutlich intuitivere Zusammenarbeit zwischen Mensch und digitalem Raum.

Im nächsten Abschnitt betrachten wir, wie diese Systeme in hochdynamischen Umgebungen – etwa in Werkhallen, Wartungsbereichen oder Schulungen – unmittelbar spürbare Effizienzgewinne erzeugen und wie KI-basierte Empfehlungen die Zusammenarbeit zwischen Teams und Technologien neu strukturieren.

Effizienz in Bewegung: Wie KI Teams in dynamischen Arbeitsräumen unterstützt

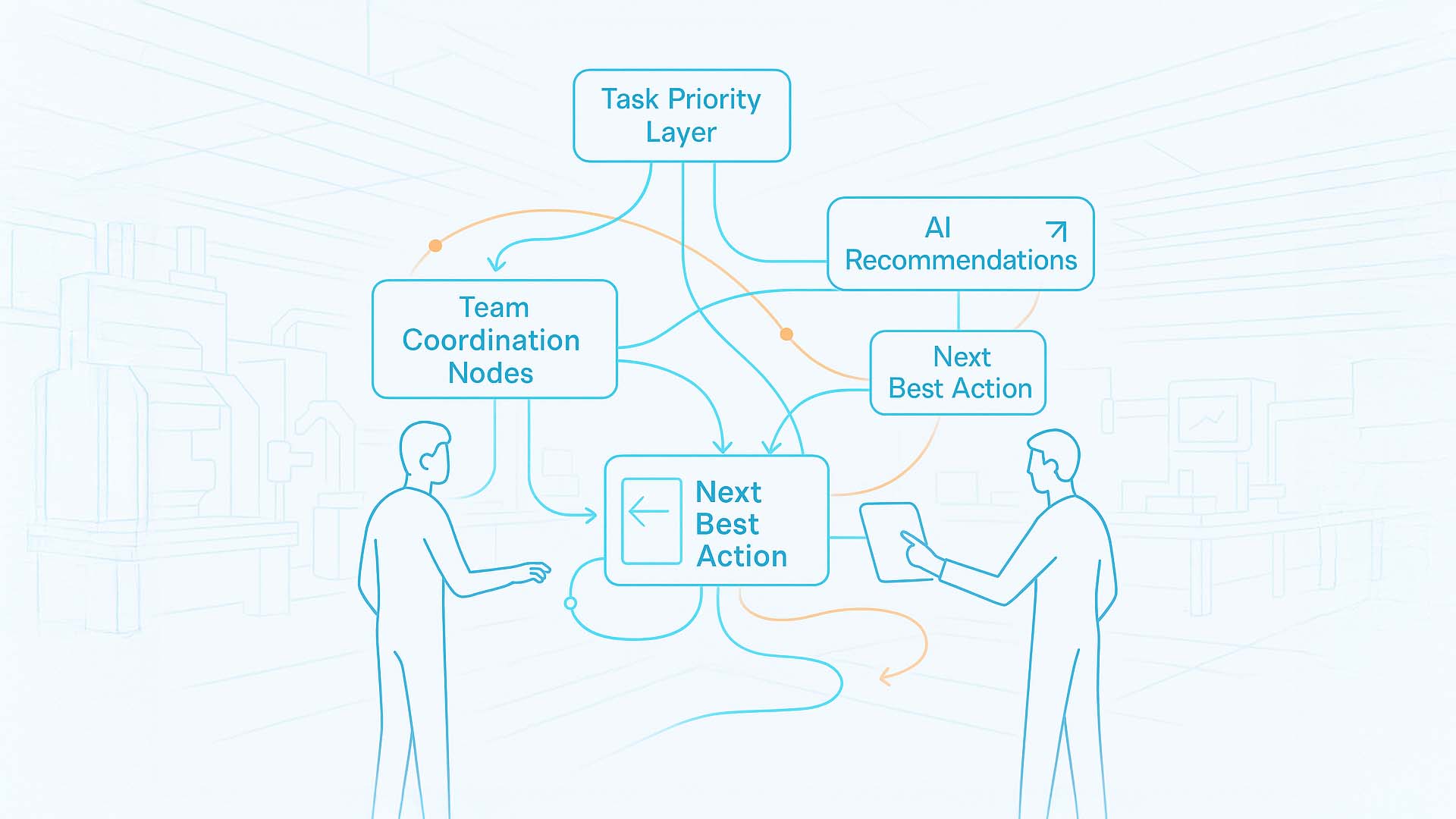

In hochdynamischen Umgebungen – von Produktionslinien über Wartungsabteilungen bis hin zu Trainingssituationen – entscheidet oft nicht ein einzelner Handgriff über den Erfolg, sondern das Zusammenspiel vieler kleiner Entscheidungen. Genau hier entfaltet KI ihr volles Potenzial: Sie erkennt Muster, koordiniert Abläufe zwischen mehreren Personen und hilft Teams, schneller und präziser zusammenzuarbeiten. Das neu erstellte Visual zeigt diesen Ansatz in einer klar strukturierten, leicht verständlichen Form: Der Arbeitsraum wird zur gemeinsamen Entscheidungsoberfläche, in der Menschen, Maschinen und KI-Schichten miteinander interagieren.

Teamorientierte KI-Unterstützung: Die Illustration zeigt, wie KI Arbeitsabläufe in Echtzeit priorisiert, koordiniert und Handlungsempfehlungen für Teams generiert.

Visualisierung: © Ulrich Buckenlei | VISORIC GmbH 2025

Das Bild zeigt zwei schematische Nutzer – links und rechts – die mit einem gemeinsamen, räumlich dargestellten Informationssystem interagieren. Zwischen ihnen verläuft ein Netz aus Linien, Knotenpunkten und UI-Elementen, die den Fluss von Informationen sichtbar machen. Die einzelnen Begriffe auf der Grafik stehen jeweils für zentrale Funktionsbereiche moderner KI-Assistenzsysteme.

- Task Priority Layer → Diese Ebene analysiert in Echtzeit, welche Aufgaben im Arbeitsprozess gerade am wichtigsten sind, und zeigt Prioritäten an, bevor sie verbal kommuniziert werden müssen.

- Team Coordination Nodes → Knotenpunkte, die anzeigen, wie die Aktivitäten mehrerer Personen miteinander verknüpft sind. Sie visualisieren, welche Person welchen nächsten Schritt übernimmt – und wohin sich der Arbeitsfluss verschiebt.

- AI Recommendations → Dynamische Vorschläge des Systems, die sich an Kontext und Situation anpassen. Sie zeigen mögliche Handlungswege, die zu höherer Effizienz oder geringerer Fehlerquote führen.

- Next Best Action → Die konkrete Handlungsempfehlung, die aus der Analyse von Umgebung, Verhalten und Prozess entsteht. Diese Empfehlung kann je nach Situation unterschiedlich sein – und wird direkt im Raum angezeigt.

- Workflow Dynamics → Kurvige Linien und Bewegungsmuster, die zeigen, wie sich Abläufe verändern, sobald ein Teammitglied eine Entscheidung trifft. Die KI macht sichtbar, wie sich die Prozesslogik weiterentwickelt.

- Real-Time Efficiency Graph → Ein kleines, aber zentrales Element des Bildes. Dieser Graph zeigt den sofortigen Einfluss von Entscheidungen auf die Gesamtleistung – ein messbarer Indikator für die Wirksamkeit des Teams.

Die Illustration verdeutlicht: Effizienz entsteht nicht durch schnellere Einzelaktionen, sondern durch intelligente Abstimmung im Raum. Durch Team Coordination Nodes wissen beide Personen intuitiv, welche Schritte sie im Zusammenspiel ausführen sollen. Die AI Recommendations und Task Priority Layer passen sich in Sekundenschnelle an Veränderungen im Ablauf an und verhindern dadurch Verzögerungen oder doppelte Arbeit. Die daraus entstehende Next Best Action wird für jeden Beteiligten sichtbar – und zwar genau dort, wo sie gebraucht wird.

Das Ergebnis: weniger Missverständnisse, weniger Fehler, eine höhere Prozessqualität und ein deutlich schnellerer Arbeitsfluss. KI wird damit nicht zum Ersatz für menschliche Teams, sondern zu ihrer gemeinsamen, vorausschauenden Entscheidungsinstanz.

Im nächsten Abschnitt zeigen wir ein reales Demonstrationsvideo, das die zuvor beschriebenen Konzepte in Aktion sichtbar macht. Es zeigt, wie KI-gestützte Umgebungen menschliche Bewegung in Echtzeit erfassen, interpretieren und als räumliche Interaktion nutzbar machen. Was bisher theoretisch beschrieben wurde, wird hier unmittelbar erfahrbar.

Digitale Bewegung wird zum Interface – das Video

Im vorherigen Abschnitt haben wir betrachtet, wie KI Arbeitsräume, Teams und Abläufe in Echtzeit versteht und vorhersieht. Doch die Grundlage all dieser Entwicklungen beginnt an einem anderen Punkt: bei der Fähigkeit, menschliche Bewegung als hochauflösendes, maschinenlesbares Signal zu interpretieren. Das folgende Video zeigt eine der derzeit eindrucksvollsten Demonstrationen dieser Technologie – ein Live-System, das volumetrische Bewegungen erkennt, analysiert und als dynamischen Datenstrom verarbeitet.

Was hier sichtbar wird, ist kein Effekt und keine Animation. Es ist die technische Basis der nächsten Interaktionsgeneration: Umgebungen, die menschliches Verhalten verstehen, bevor ein klassisches Interface überhaupt ins Spiel kommt. Genau diese maschinenlesbare Bewegung ist es, die adaptive Sicherheitssysteme, spatial robotics und KI-native Arbeitsumgebungen überhaupt erst möglich macht.

Demonstration von Echtzeit-Volumenbewegung: Bewegungsdaten als maschinenlesbare Struktur.

Technology: augmenta.tech · Processing: TouchDesigner · Filming: studio.lablab · Voiceover: Ulrich Buckenlei · Fair Use for analytical purpose

Dieses Video ist der Brückenschlag zwischen Forschung, industrieller Praxis und den KI-gestützten Interaktionsmodellen, die wir in den vorigen Kapiteln beschrieben haben. Es zeigt nicht nur, wie Bewegung analysiert wird – es zeigt, wie sich der gesamte Begriff von Interaktion verändert. Sobald Verhalten maschinenlesbar wird, entsteht eine völlig neue Klasse digitaler Systeme: schnell, vorausschauend, räumlich und autonom.

Im abschließenden Kapitel richten wir den Blick darauf, wie Unternehmen diese Entwicklungen heute bereits nutzen können – und wie das VISORIC Expertenteam in München Organisationen dabei unterstützt, die ersten konkreten Schritte in diese neue Generation räumlicher Interaktionen zu gehen.

Das VISORIC Expertenteam in München

Die in diesem Artikel beschriebenen Entwicklungen – von räumlicher Interaktion über KI-gestützte Assistenzsysteme bis hin zu vorausschauenden Workflows – entstehen nicht im luftleeren Raum. Sie wachsen dort, wo Forschung, Design, Softwareentwicklung und räumliche Visualisierung konsequent zusammengeführt werden. Genau das ist der Ansatz des VISORIC Expertenteams in München.

Unser Fokus liegt darauf, komplexe Zukunftstechnologien so aufzubereiten, dass sie für Unternehmen unmittelbar nutzbar werden. Ob es um den Aufbau räumlicher Interaktionsmodelle, die Integration von KI-Prozessen in industrielle Abläufe oder das Design intuitiver 3D-Interfaces geht: Entscheidend ist immer die Verbindung von technischer Tiefe und praktischer Anwendbarkeit.

- Strategische Entwicklung → Analyse von Prozessen, Räumen und Potenzialen für KI-gestützte Interaktion

- Räumliches Interface-Design → Entwicklung klarer volumetrischer UI-Logiken für Produktion, Training und Service

- Technische Umsetzung → Integration von KI-Schichten, Echtzeit-Motion-Intelligence und Spatial Computing Workflows

- Prototyping & Skalierung → Von ersten Demonstratoren bis zur produktionsreifen Enterprise-Lösung

Das VISORIC Expertenteam: Ulrich Buckenlei und Nataliya Daniltseva im Austausch über KI-gestützte Interaktion, Spatial Computing und zukünftige Arbeitsprozesse.

Quelle: VISORIC GmbH | München 2025

Das gezeigte Teamfoto steht stellvertretend für unsere Arbeitsweise: Wir verbinden Präzision im Detail mit dem Blick für das große Ganze. Viele Projekte beginnen mit ersten visuellen Skizzen oder technischen Modellen – und wachsen Schritt für Schritt zu robusten, immersiven Systemen, die echten Mehrwert schaffen. Dabei spielt eine zentrale Rolle, dass wir Technologien nie isoliert betrachten, sondern stets im räumlichen, organisatorischen und menschlichen Kontext.

Wenn Sie darüber nachdenken, eigene Systeme für räumliche Interaktion, KI-gestützte Analyseprozesse oder immersive Produktentwicklung zu entwickeln, begleiten wir Sie gerne. Schon ein erstes Gespräch kann ausreichen, um Potenziale sichtbar zu machen und konkrete nächste Schritte zu identifizieren.

Kontaktpersonen:

Ulrich Buckenlei (Kreativdirektor)

Mobil: +49 152 53532871

E-Mail: ulrich.buckenlei@visoric.com

Nataliya Daniltseva (Projektleiterin)

Mobil: + 49 176 72805705

E-Mail: nataliya.daniltseva@visoric.com

Adresse:

VISORIC GmbH

Bayerstraße 13

D-80335 München