Ultradünne Haptik macht digitale Texturen fühlbar: Ein futuristisches Fingermodell demonstriert VoxeLite – eine neue Technologie, die Berührung auf glatten Displays präzise simuliert.

Bild: © Ulrich Buckenlei | VISORIC GmbH 2025

Digitale Oberflächen beginnen sich zu verändern. Lange waren Bildschirme reine Seh- und Hörmedien, doch aktuelle Forschung zeigt, wie sich auch der Tastsinn in die digitale Interaktion integrieren lässt. Das Forschungsprojekt VoxeLite der Northwestern University gilt als einer der ersten realen Schritte in diese Richtung. Die Technologie erzeugt fühlbare Mikrostrukturen auf vollständig glatten Displays und lässt digitale Inhalte zum ersten Mal physisch erlebbar werden.

Was bislang nur in Science-Fiction-Filmen denkbar war – etwa das Ertasten eines Materials, einer Form oder eines Mikromusters über eine digitale Oberfläche – rückt damit in greifbare Nähe. Das extrem dünne, flexible Haptik-Interface von VoxeLite formt sich wie eine zweite Haut an den Finger und erzeugt durch mikroskopische Aktuatorfelder ein präzises, dynamisches Reibungsmuster. Auf diese Weise entstehen fühlbare Texturen, die im Experiment bereits mit beeindruckender Genauigkeit erkannt wurden.

Diese Entwicklung markiert einen entscheidenden Moment für die nächste Generation von Interfaces. Sie verbindet wissenschaftliche Präzision mit alltäglicher Interaktion und öffnet den Weg zu Anwendungen, die weit über klassische Touchscreens hinausgehen – von smarter Industrie über Robotik bis hin zu immersiven Lern- und Trainingsumgebungen.

Um zu verstehen, wie VoxeLite physische Texturen auf digitalen Oberflächen erzeugt, lohnt sich zunächst ein Blick auf das grundlegende Prinzip hinter der Technologie: die gezielte Veränderung von Reibung und Mikrostruktur an der Fingerkuppe, ausgelöst durch mikroskopische Aktuatoren.

Unsichtbare Interaktion beginnt mit Mikrostrukturen

Das Prinzip der digitalen Berührung entsteht nicht auf dem Display, sondern am Finger selbst. Erst wenn die Haut minimale Veränderungen in Reibung, Struktur oder Oberflächendruck wahrnimmt, entsteht das Gefühl einer echten Textur. VoxeLite setzt genau hier an: Die Technologie verwandelt Bewegung der Fingerkuppe in maschinenlesbare Signale und erzeugt daraus fühlbare Muster, die das Gehirn wie echte Materialien interpretiert.

Bevor eine digitale Oberfläche als „rauh“, „körnig“ oder „weich“ empfunden wird, passiert im Hintergrund ein hochpräziser Prozess. Mikroaktoren verändern Reibung im Millisekundentakt, modulieren winzige Kraftimpulse und erzeugen Mikrostrukturen, die sich nahtlos an die Bewegung des Fingers anpassen. Die Fingerkuppe wird dadurch zum Interaktionszentrum – nicht das Display.

Um diesen Prozess verständlich zu machen, zeigt die folgende Illustration die zentralen Elemente, aus denen fühlbare digitale Texturen entstehen.

- Mikroskopische Aktuatoren – winzige Reibungsmodulatoren, die Reibung punktgenau erhöhen oder verringern.

- Fingertip Resolution – die Aktuatorabstände orientieren sich an der 1–2 mm Auflösungsgrenze des menschlichen Tastsinns.

- Dynamische Reibungsmuster – Mikrostrukturen verändern sich in Echtzeit und folgen jeder Fingerbewegung.

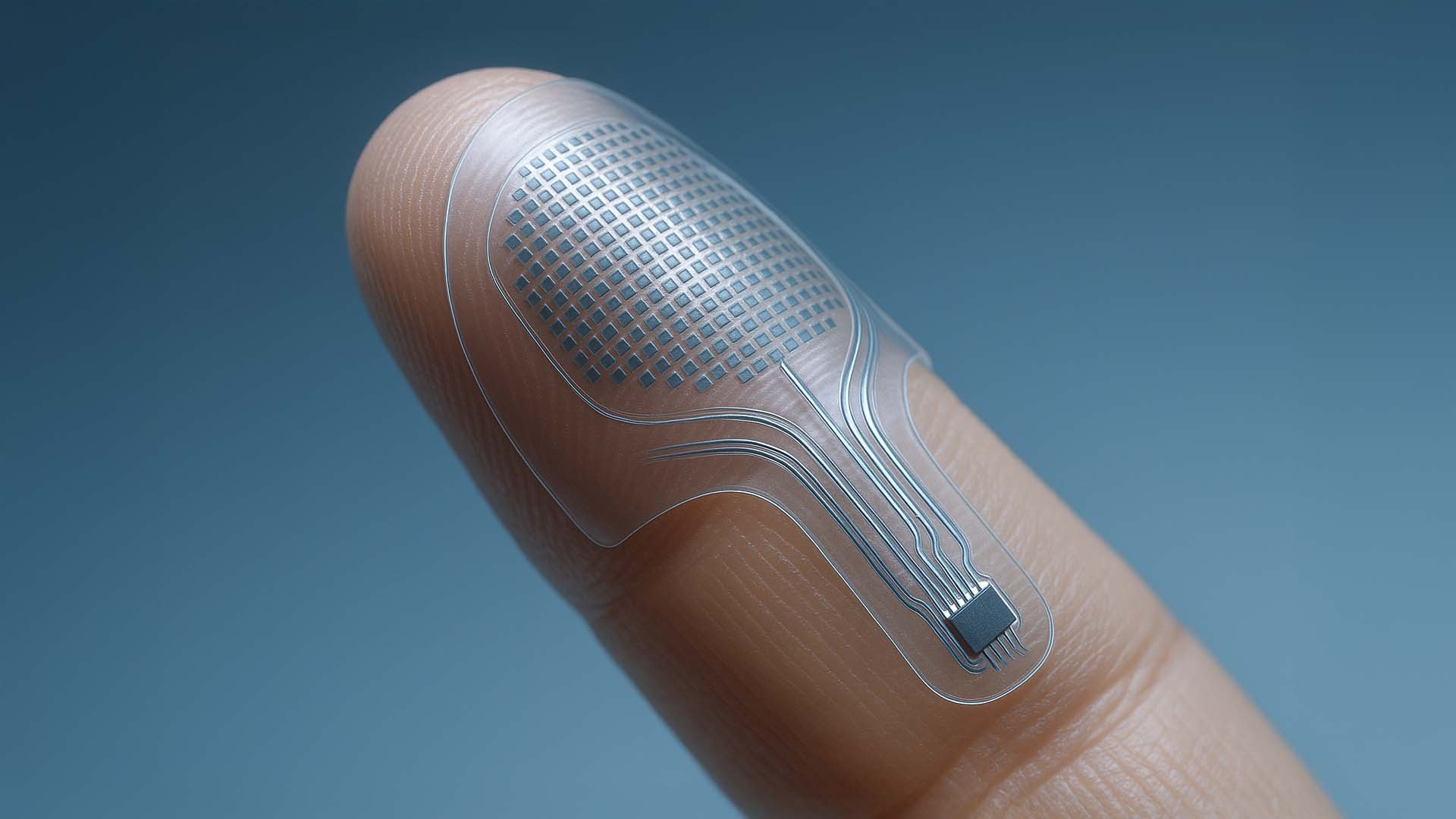

Transparente Mikroaktor-Schicht auf der Fingerkuppe: Das flexible VoxeLite-Interface zeigt ein hochdichtes Aktuatorfeld und integrierte, ultradünne Leiterbahnen, die Reibung präzise modulieren.

Bild: © Ulrich Buckenlei | VISORIC GmbH 2025

Die Abbildung zeigt eine ultradünne, transparente Haptikschicht, die sich wie eine zweite Haut an die Fingerkuppe legt. Die quadratische Mikrostruktur bildet ein dichtes Feld elektrostatischer Aktuatoren, das sich exakt über den Bereich legt, in dem der Mensch am empfindlichsten fühlt. Die feinen Leiterbahnen transportieren hochfrequente Signale zu einem winzigen Steuermodul – flexibel, kaum sichtbar und dennoch leistungsfähig genug, um Reibung im Millisekundenbereich zu verändern. Erst diese präzise Verschmelzung von Material und Elektronik ermöglicht es, dass flache Displays fühlbar werden.

Im nächsten Abschnitt betrachten wir, wie diese mikrostrukturellen Signale zu vollständigen digitalen Texturen zusammenwachsen und warum zeitliche Auflösung dabei eine entscheidende Rolle spielt.

Wie aus Mikroimpulsen vollständige digitale Texturen entstehen

Digitale Haptik beginnt auf der Ebene einzelner Mikroaktoren, doch erst die zeitliche Abfolge ihrer Signale erzeugt das Gefühl einer echten Oberfläche. Der menschliche Tastsinn interpretiert Reibungsänderungen nicht isoliert, sondern als fortlaufende Muster. VoxeLite nutzt dieses Prinzip, indem das System hunderte Mikroimpulse pro Sekunde zu strukturierten „Texture Frames“ kombiniert, die sich präzise an die Fingerbewegung anpassen.

Ist der Finger in Bewegung, entstehen winzige Reibungswellen auf der Haut – ähnlich wie Körnung, Faserverläufe oder feine Materialrippen. Werden diese Impulse schnell genug verändert, verschmelzen sie zu einem kontinuierlichen haptischen Eindruck, der sich wie eine echte physische Oberfläche anfühlt. Die technologische Herausforderung liegt dabei nicht nur in der räumlichen, sondern besonders in der zeitlichen Auflösung.

Um diesen Prozess sichtbar zu machen, zeigt die folgende Infografik die wichtigsten Ebenen, aus denen VoxeLite fühlbare digitale Texturen erzeugt.

- Micro Actuator Nodes – winzige Punkte, die Reibung lokal und hochpräzise modulieren.

- Texture Frames – Sequenzen aus Mikrostrukturen, die mit bis zu 800 Hz erzeugt werden.

- Somatosensory Interpretation – das Zusammenspiel verschiedener Hautrezeptoren, die die Muster als „Oberfläche“ wahrnehmen.

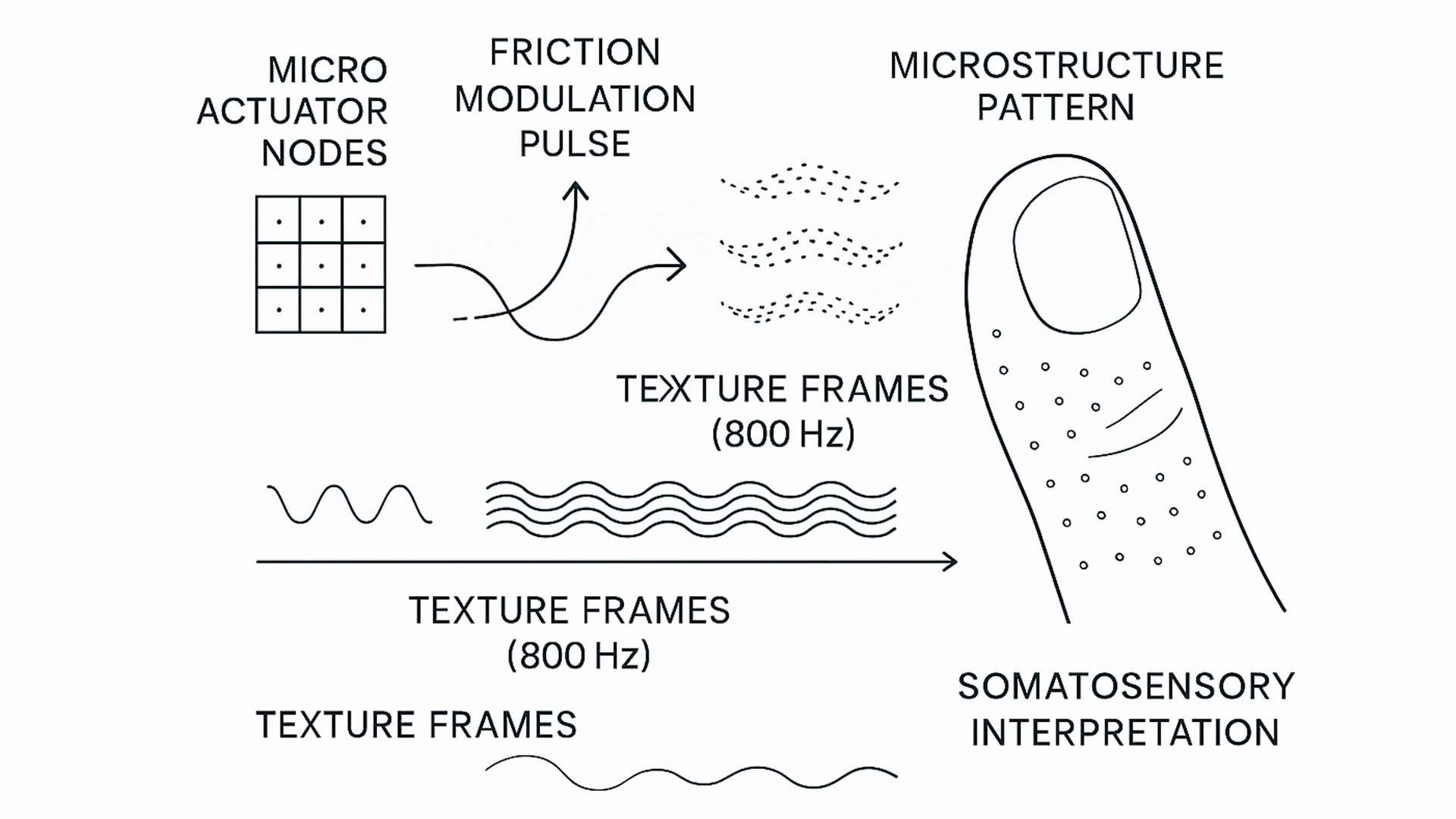

Infografik: Wie digitale Texturen entstehen – von einzelnen Mikroaktoren über Reibungsimpulse bis hin zu vollständigen Texturmustern, die der Tastsinn als reale Materialeigenschaft interpretiert.

Bild: © Ulrich Buckenlei | VISORIC GmbH 2025

Die Grafik zeigt links ein vereinfachtes Raster von Mikroaktoren, das die Grundlage für alle haptischen Effekte bildet. Jeder dieser Punkte kann die Reibung an der Haut minimal erhöhen oder verringern. Darüber liegen wellenförmige Linien, die symbolisieren, wie einzelne Impulse moduliert werden, bevor sie zu einem Muster zusammenwachsen. In der Mitte entsteht daraus eine Mikrostruktur: eine Art „haptischer Frame“, der in seiner Form an Körnung, Textur oder Richtungsstruktur erinnert.

Entscheidend ist die zeitliche Sequenz auf der horizontalen Achse. VoxeLite erzeugt solche Frames mit bis zu 800 Hertz – schnell genug, damit das Gehirn sie nicht als einzelne Impulse, sondern als fließende Materialeigenschaft wahrnimmt. Die rechte Seite der Infografik zeigt eine stilisierte Fingerkuppe mit Punkten, die die verschiedenen Mechanorezeptoren darstellen. Diese Rezeptoren (wie RA1 und SA1) reagieren jeweils auf unterschiedliche Muster: Vibrationen, feine Strukturen oder Druckgradienten. Erst die Kombination dieser Signale ermöglicht es, dass eine glatte digitale Oberfläche sich wie Holz, Stoff oder Stein anfühlen kann.

Im nächsten Abschnitt gehen wir einen Schritt weiter und betrachten, wie VoxeLite nicht nur statische Texturen, sondern auch dynamische Materialeffekte erzeugt – etwa Richtungsmuster, Kanten oder wechselnde Oberflächen, die sich während der Fingerbewegung verändern.

Wenn Oberflächen lebendig werden: Dynamische Texturen in Echtzeit

Statische Mikrostrukturen können bereits erstaunlich präzise Materialeindrücke erzeugen, doch das volle Potenzial von VoxeLite zeigt sich erst dann, wenn die Textur während der Bewegung des Fingers aktiv mitarbeitet. Der Tastsinn reagiert nicht nur auf Form, sondern besonders stark auf Veränderungen: Richtungswechsel, Kanten, Übergänge und mikroskopische Kraftverschiebungen. Genau hier setzt die dynamische Texturerzeugung von VoxeLite an. Das System moduliert Reibung nicht als festen Zustand, sondern als kontinuierliches Muster, das sich im Millisekundentakt erneuert.

Dadurch entsteht das Gefühl von „lebenden Oberflächen“. Die Haptik verändert sich abhängig von Richtung, Geschwindigkeit und Druck der Fingerbewegung. Ein Muster kann sich gegen die Bewegungsrichtung aufstellen, als fühlbare Rille nach links verlaufen oder sich beim Überfahren einer digitalen „Kante“ abrupt verändern. Diese Effekte sind nicht vorgerendert, sondern werden in Echtzeit generiert – und ermöglichen damit völlig neue, adaptive Interaktionsformen für Training, Design, Simulation und Barrierefreiheit.

- Directional Texture Pattern – fühlbare Muster, die sich entlang einer bestimmten Richtung verstärken oder abschwächen.

- Edge Modulation Zone – lokale Reibungsänderungen, die eine klar abgegrenzte Kante simulieren.

- Dynamic Friction Shift – fließende Reibungsverschiebungen, die sich während der Fingerbewegung kontinuierlich anpassen.

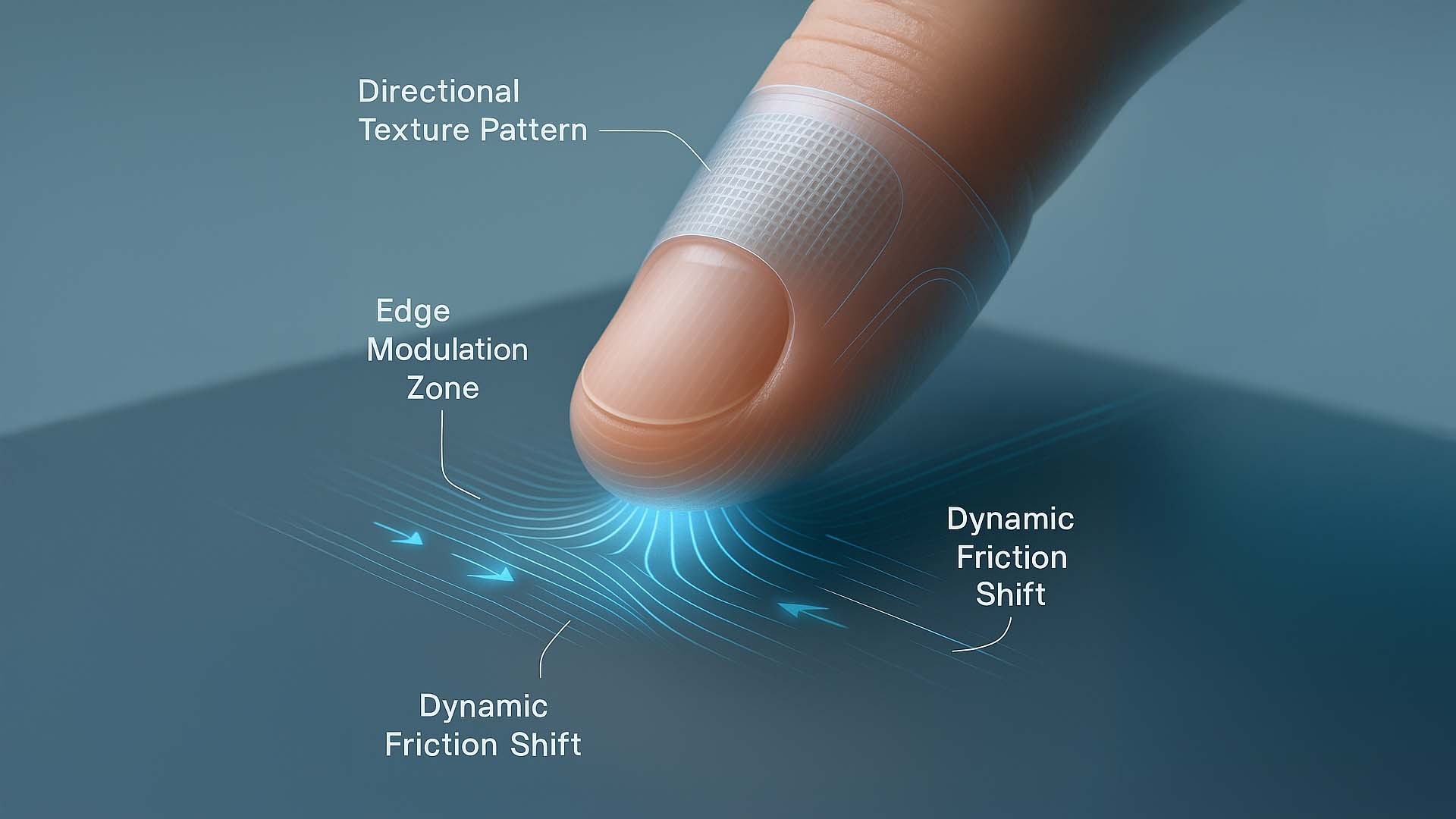

Dynamische Haptik in Aktion: Die Abbildung zeigt, wie VoxeLite während der Fingerbewegung gerichtete Texturmuster, fühlbare Kanten und fließende Reibungsänderungen erzeugt. Das Ergebnis ist eine Oberfläche, die sich nicht statisch, sondern lebendig und situationsabhängig anfühlt.

Bild: © Ulrich Buckenlei | VISORIC GmbH 2025

Im oberen Bereich der Illustration ist das Directional Texture Pattern zu sehen: ein feines Netzwerk aus Mikromustern, das sich entlang der Bewegungsrichtung verändert. Diese Muster entstehen durch modulierte Mikroaktoren, die Reibung gezielt verstärken oder reduzieren – ähnlich dem Gefühl, mit dem Finger über Holzfasern oder eine geriffelte Metallkante zu streichen.

Links unter dem Finger befindet sich die Edge Modulation Zone. Hier erzeugt VoxeLite eine abrupt spürbare Änderung im Reibungsprofil, die sich wie eine echte physische Kante anfühlt. Das System kann diesen Effekt dynamisch platzieren, etwa um Objekte, Schaltflächen oder Grenzen spürbar zu machen.

Rechts und unten visualisieren Wellenlinien die Dynamic Friction Shift. Diese Reibungsverschiebungen folgen dem Finger in Echtzeit und erzeugen ein Gefühl von Bewegung in der Oberfläche selbst. Das verleiht digitalen Materialien erstmals eine Art haptische Fluidität – vergleichbar mit Stoff, der sich verändert, wenn man darüber streicht, oder einer Oberfläche, die Richtungsinformationen vermittelt.

Der folgende Abschnitt zeigt, welche Möglichkeiten sich aus diesen Erkenntnissen für zukünftige Interaktionsmodelle ergeben. Forschungsprojekte wie VoxeLite deuten an, wie digitale Oberflächen eines Tages nicht nur sichtbar, sondern auch intuitiv fühlbar werden könnten.

Zukünftige Interaktionen: Wie fühlbare Interfaces entstehen könnten

Die in VoxeLite demonstrierten Prinzipien zeigen nicht nur, wie digitale Texturen entstehen, sondern eröffnen auch neue Möglichkeiten für Interaktionen, die weit über klassische Touch-Oberflächen hinausgehen. Wenn Reibung, Kanten und Richtungen digital formbar werden, können Displays theoretisch zu fühlbaren Bedienfeldern werden – ohne dass physische Tasten oder Strukturen vorhanden sein müssen. Forschungsprojekte wie VoxeLite deuten an, wie digitale Oberflächen eines Tages nicht nur sichtbar, sondern auch intuitiv fühlbar werden könnten.

Diese Perspektive verändert die Rolle von Interfaces grundlegend. Statt ausschließlich visuelle Rückmeldung zu bieten, könnten zukünftige Systeme Informationen über den Tastsinn vermitteln. Buttons könnten als kleine Erhebung spürbar werden, obwohl die Oberfläche glatt bleibt. Werkzeuge – etwa Slider, Drehregler oder Auswahlfelder – könnten fühlbare Führungslinien besitzen. Und selbst komplexere Formen wie Objekte, Materialübergänge oder Widerstandszonen könnten haptisch simuliert werden, sodass Nutzende Strukturen ertasten, ohne dass sie physisch existieren.

- Touch Surface Feedback – eine glatt bleibende Oberfläche, die fühlbar reagiert, sobald der Finger Kontakt aufnimmt.

- Virtual Button – ein digitales Bedienelement, das beim Drücken eine fühlbare Druckzone oder Gegenkraft simuliert.

- Object Interaction – dynamische Formen oder Werkzeuge, die ihre haptischen Eigenschaften an Bewegung und Kontext anpassen.

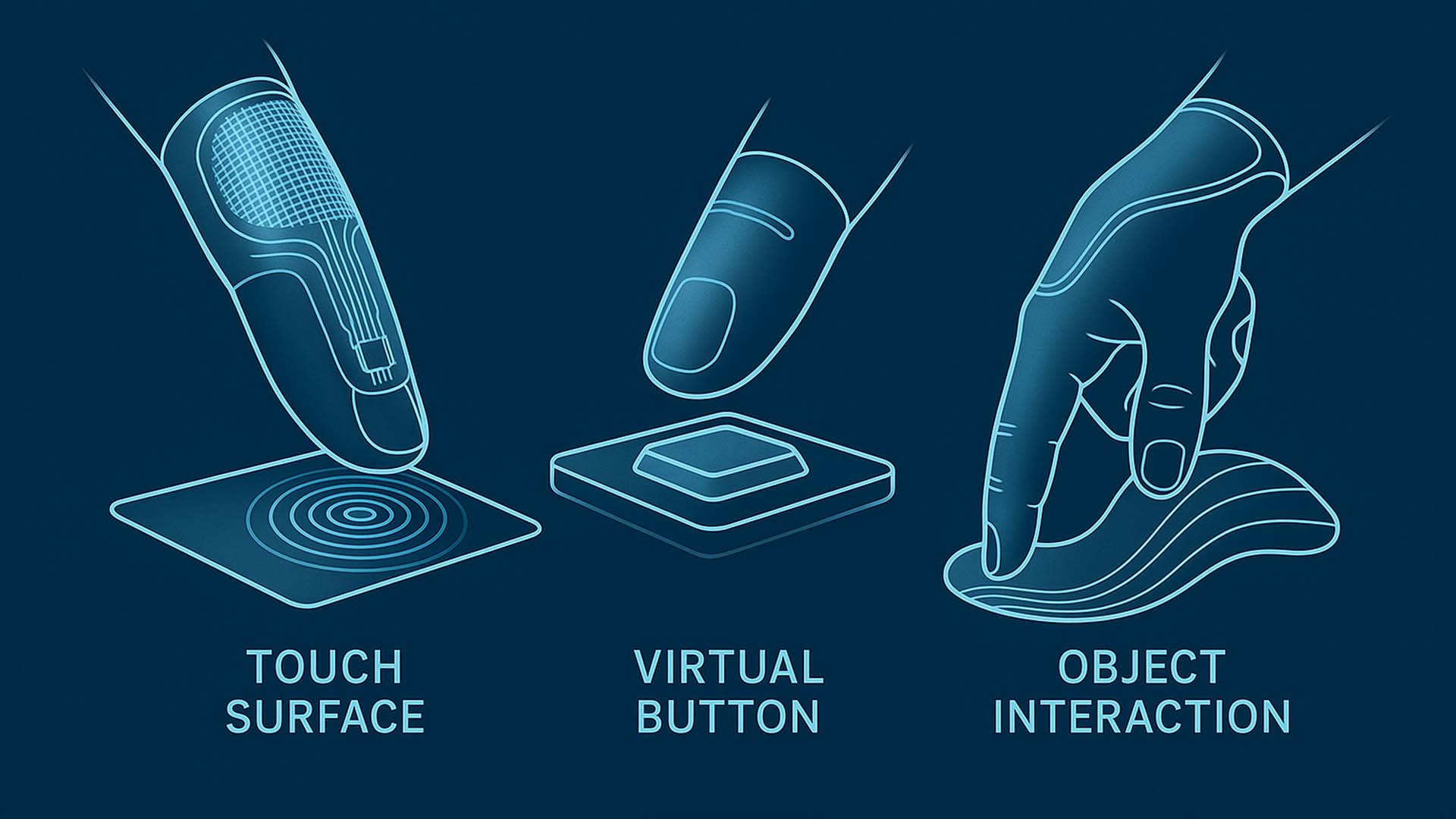

Zukunft haptischer Interfaces: Die Grafik zeigt drei grundlegende Interaktionskonzepte, die sich aus den VoxeLite-Prinzipien ableiten lassen – fühlbare Oberflächen, virtuelle Buttons und dynamische Objektformen, die sich an Bewegung und Kontext anpassen.

Bild: © Ulrich Buckenlei | VISORIC GmbH 2025

Die Infografik visualisiert drei exemplarische Anwendungsszenarien, die zukünftige haptische Interfaces ermöglichen könnten. Links zeigt der Bereich Touch Surface eine glatte Oberfläche, die über subtile Kreiswellen fühlbare Rückmeldungen erzeugt, sobald die Fingerkuppe Kontakt herstellt. Diese Wellen stehen symbolisch für modulierte Reibungsimpulse, die sich wie eine vibrierende oder strukturierte Zone anfühlen könnten.

Im Zentrum sieht man das Konzept des Virtual Button. Obwohl die Oberfläche flach bleibt, erzeugt ein lokal verstärktes Reibungsmuster ein taktiles Druckgefühl. Die Illustration zeigt, wie ein einzelner digitaler Button fühlbar hervortreten und auf eine Berührung reagieren könnte – eine Art haptischer Klick, der ohne Mechanik auskommt.

Rechts stellt die Grafik Object Interaction dar. Hier interagiert ein Finger mit einer abstrahierten, weich wirkenden Form. Dieses Element symbolisiert dynamische, anpassbare Strukturen: virtuelle Werkzeuge oder Materialien, die sich in Echtzeit verändern, wenn man sie „berührt“. Solche Effekte könnten eines Tages das Ertasten von Formen, Kanten, Werkzeugspuren oder sogar 3D-Geometrien ermöglichen.

Der folgende Abschnitt zeigt, wie diese Konzepte weitergedacht werden können – etwa für Training, Simulation, Barrierefreiheit oder industrielle Interfaces, die Nutzenden nicht nur visuelle, sondern auch haptische Orientierung bieten.

Wenn digitale Berührung neue Anwendungswelten öffnet

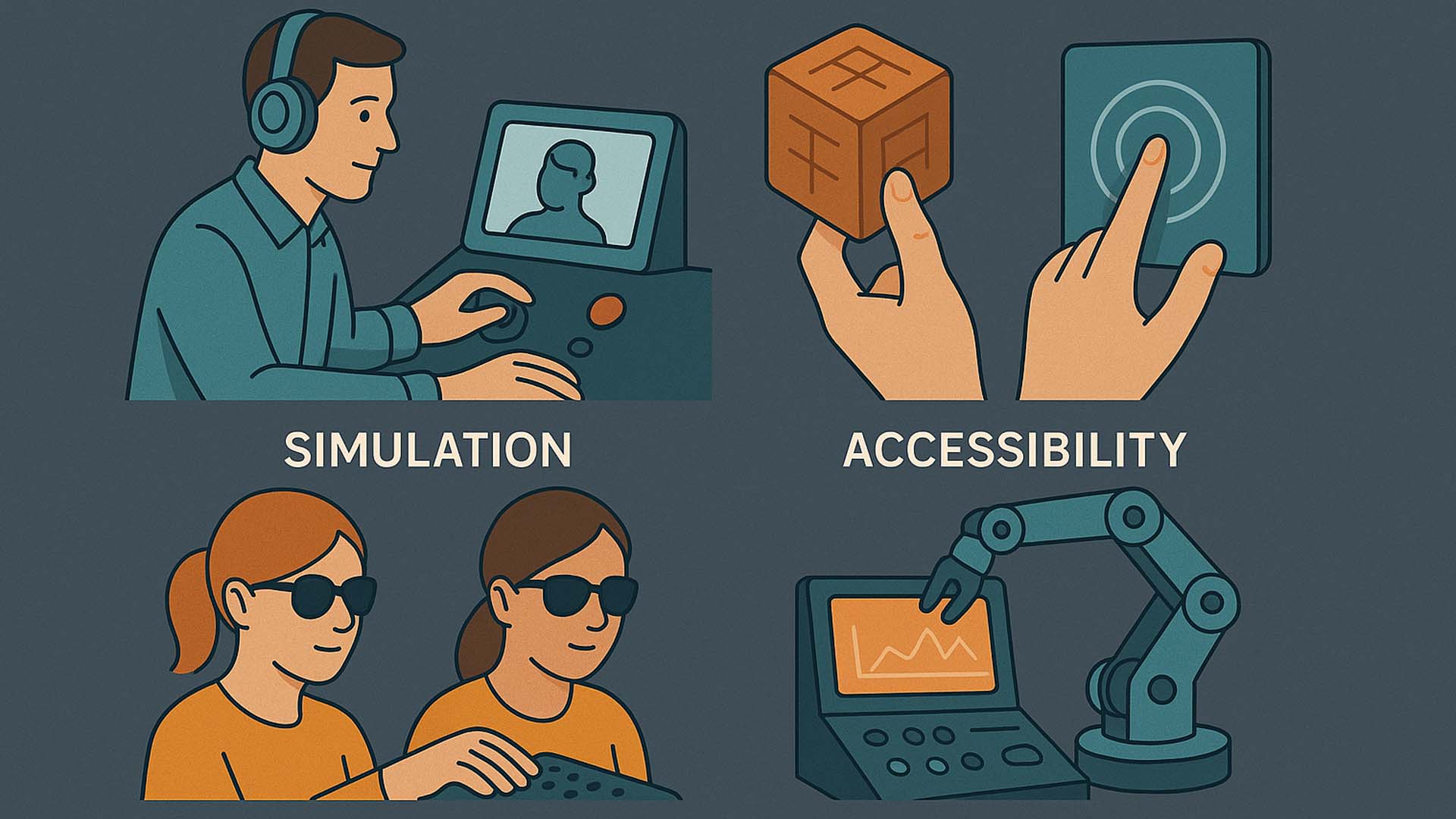

Während VoxeLite heute vor allem als Forschungsprototyp existiert, zeigt ein Blick auf mögliche Einsatzfelder, welches Potenzial in präzise fühlbaren digitalen Oberflächen steckt. Ob Training, Barrierefreiheit, Simulation oder industrielle Steuerung – überall dort, wo Menschen Informationen nicht nur sehen, sondern spüren müssen, entstehen völlig neue Formen der Interaktion. Die folgende Illustration fasst vier zentrale Anwendungsszenarien zusammen, wie taktile Interfaces den Alltag und die Arbeitswelt in den kommenden Jahren verändern könnten.

Vier Zukunftsszenarien für haptische Interfaces: Simulation, Barrierefreiheit, Training und industrielle Steuerung. Die Illustration zeigt, wie fühlbare digitale Oberflächen neue Wege der Interaktion eröffnen – von realitätsnahem Lernen bis hin zu barrierefreien Informationssystemen.

Bild: © Ulrich Buckenlei | VISORIC GmbH 2025

Die Grafik teilt sich in vier klar abgegrenzte Bereiche, die jeweils ein zentrales Szenario repräsentieren, in dem digitale Haptik einen entscheidenden Mehrwert bietet:

- Simulation – Ob medizinische Ausbildungen, Maschinenbedienung oder Notfalltraining: Realistische haptische Rückmeldungen können das Lernen sicherer, präziser und messbarer machen. In der Illustration sieht man eine Person, die über eine Konsole simulierte Eingriffe oder Arbeitsabläufe steuert – unterstützt durch fühlbare Parameter wie Widerstand, Struktur oder Vibrationsmuster. So entsteht ein Lernumfeld, das nah an realen Bedingungen liegt, ohne reale Risiken.

- Accessibility – Für Menschen mit Sehbehinderung können fühlbare digitale Oberflächen zu einer völlig neuen Form der Informationswahrnehmung führen. Das Bild zeigt zwei Nutzerinnen, die ein taktiles Interface erkunden, das Texte, Muster oder Richtungsinformationen fühlbar macht. Haptische Pixel ersetzen visuelle Elemente und machen digitale Inhalte unmittelbar verständlich – eine der vielversprechendsten Visionen der nächsten Interface-Generation.

- Training – Digitale Haptik ermöglicht realistische Interaktion, ohne aufwendige Hardware oder reale Materialien. Von handwerklichen Tätigkeiten bis hin zu chirurgischen Bewegungsabläufen: Berührungssimulationen schaffen eine Zwischenstufe zwischen Übung und Realität. Die Illustration zeigt ein haptisches Trainingssystem, bei dem Nutzerinnen virtuelle Objekte erfühlen und Bewegungsabläufe einstudieren können, unterstützt durch dynamische Reibungsmuster oder fühlbare Konturen.

- Industrielle Interfaces – Präzise fühlbare Signale können Maschinensteuerung revolutionieren. Das Bild zeigt ein robotisches System, dessen Bedienkonsole mit haptischen Feedbackpunkten ausgestattet ist. Operatorinnen und Operatoren könnten dadurch Zustände oder Warnungen nicht mehr nur sehen, sondern fühlen – ein Vorteil in lauten Umgebungen oder dort, wo visuelle Aufmerksamkeit gebunden ist. Außerdem wird die Bedienung robuster und intuitiver, weil relevante Informationen direkt über die Fingerkuppen vermittelt werden.

Was all diese Szenarien verbindet, ist die Idee, dass digitale Informationen nicht mehr ausschließlich visuell oder auditiv konsumiert werden. Stattdessen werden sie als physische Empfindung erlebbar. VoxeLite liefert dafür die technologische Grundlage: ein ultradünnes Interface, das kleinste Signale präzise abbilden kann. Aus dieser Kombination entsteht ein neues Interaktionsparadigma – eines, das menschliche Sinne nicht ersetzt, sondern erweitert.

Im nächsten Abschnitt betrachten wir, wie sich diese Konzepte weiterentwickeln könnten, wenn VoxeLite und ähnliche Technologien in Anwendungen wie Simulation, Remote-Control oder barrierefreie Informationssysteme integriert werden. Dabei rückt der Gedanke in den Fokus, dass fühlbare Interfaces nicht nur Aufgaben erleichtern, sondern ganz neue Formen menschlicher Wahrnehmung ermöglichen.

Wenn Forschung zu Technologie wird – der Weg von VoxeLite in reale Systeme

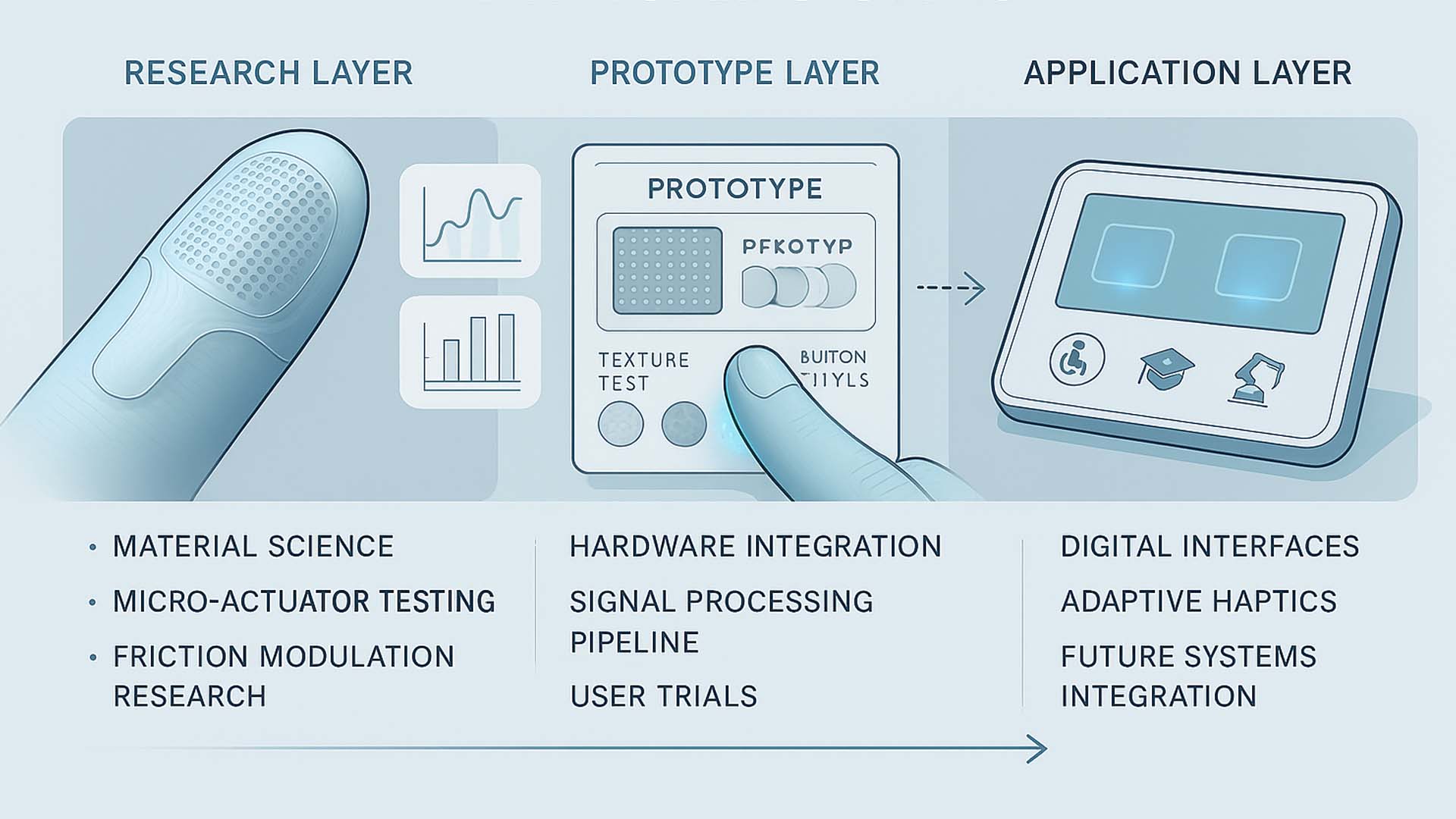

Während VoxeLite heute noch im Labor existiert, lässt sich bereits klar erkennen, welche technologischen Schritte notwendig sind, um aus einem experimentellen Haptik-Interface ein vollwertiges Interaktionssystem zu machen. Die Entwicklung verläuft dabei nicht linear, sondern in drei aufeinander abgestimmten Ebenen: Grundlagenforschung, Prototyping und Systemintegration. Die folgende Infografik zeigt diese Evolution – und macht sichtbar, wie aus einzelnen Mikrostrukturen schließlich komplette, funktionale Interfaces entstehen können.

Von der Forschung zur Anwendung: Die Grafik zeigt drei Entwicklungsstufen haptischer Technologien – von ersten Reibungsexperimenten (Research Layer) über frühe Testmodule (Prototype Layer) bis hin zu zukünftigen Interfaces, in denen fühlbare Signale in alltägliche Geräte integriert werden.

Bild: © Ulrich Buckenlei | VISORIC GmbH 2025

Die Illustration gliedert die Technologieentwicklung in klar getrennte Bereiche. Links beginnt der Research Layer, in dem mikroskopische Aktuatoren getestet und Materialeigenschaften analysiert werden. In der Mitte befindet sich der Prototype Layer, der zeigt, wie einzelne Elemente zu funktionalen Testgeräten zusammengeführt werden. Rechts folgt der Application Layer, der veranschaulicht, wie fühlbare Interfaces eines Tages in reale Produkte oder Arbeitsumgebungen integriert sein könnten.

- Research Layer – Dieser Abschnitt zeigt, wie wissenschaftliche Grundlagen geschaffen werden. Zu sehen sind Fingermodelle, Aktuatorgrids und schematische Reibungsdiagramme, die dokumentieren, wie präzise Signale erzeugt und messbar gemacht werden. Hier entsteht das Fundament: Materialtests, Friktionsmodulation und die Frage, welche Muster Menschen überhaupt unterscheiden können.

- Prototype Layer – In der Mitte der Grafik erkennt man erste Hardwaremodule, die aus Forschungskomponenten zusammengesetzt sind. Sie ermöglichen Nutzerstudien, Latenzmessungen und das Testen von Signalformen. Hier entscheidet sich, ob eine Technologie wiederholbar, stabil und ergonomisch genug ist, um in reale Systeme überzugehen.

- Application Layer – Der rechte Bereich zeigt symbolisch die Zukunft: Konsolen, Bedienfelder oder Assistenzsysteme, die fühlbare Rückmeldungen nutzen. Ob Barrierefreiheit, Industrie oder Training – dieser Layer steht für das Ziel, digitale Informationen nicht nur sichtbar oder hörbar zu machen, sondern physisch erfahrbar.

Das Zusammenspiel dieser Ebenen macht deutlich, dass VoxeLite nicht einfach ein neues Interface ist, sondern eine Plattformtechnologie. Sie kann sich in unterschiedlichste Systeme integrieren und neue Arten digitaler Wahrnehmung ermöglichen. Forschung liefert die Bausteine, Prototypen machen sie erfahrbar und Anwendungen verwandeln sie in nutzerzentrierte Funktionen.

Der folgende Abschnitt zeigt, welche Perspektiven sich eröffnen, wenn diese technologischen Grundlagen weitergedacht werden – etwa für Simulation, Remote-Control, Barrierefreiheit oder neue Formen sensorischer Kommunikation. Dabei rückt in den Mittelpunkt, wie fühlbare digitale Signale den Umgang mit Maschinen, Tools und Informationen grundlegend verändern könnten.

Wenn KI haptische Signale verstärkt – adaptive Berührung als neues Interface

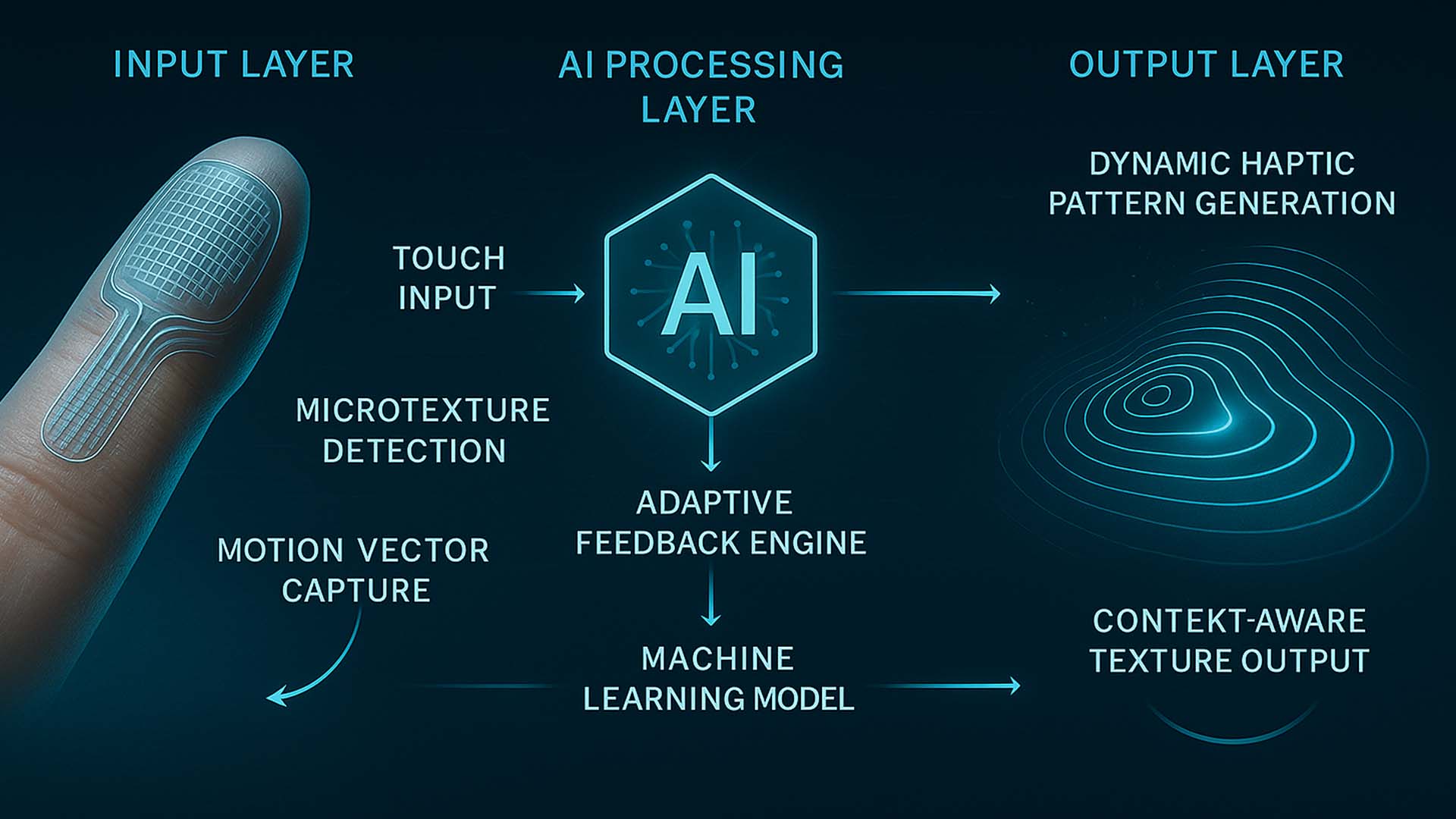

Die nächste Evolutionsstufe von VoxeLite entsteht dort, wo Haptik auf künstliche Intelligenz trifft. Während mikrostrukturelle Aktuatoren fühlbare Signale erzeugen, kann KI diese Signale interpretieren, anpassen und kontextbezogen verstärken. Aus einer festen Textur wird ein dynamisches Feedbacksystem, das auf Absichten reagiert, Bewegungen versteht und Berührungen semantisch deutet. Die folgende Infografik zeigt diesen Prozess in drei klar abgegrenzten Schichten – vom menschlichen Input bis zur KI-generierten Rückmeldung.

AI-Enhanced Haptic Feedback Loop: Die Grafik visualisiert, wie Berührungen erfasst, durch KI interpretiert und in dynamische haptische Muster übersetzt werden. Links der Fingereingang mit Mikrostrukturerkennung, in der Mitte die KI-Verarbeitung, rechts die adaptive Ausgabe fühlbarer Texturen.

Bild: © Ulrich Buckenlei | VISORIC GmbH 2025

Die Infografik ist in drei Ebenen gegliedert, die gemeinsam erklären, wie KI zu einem entscheidenden Bestandteil zukünftiger haptischer Interfaces wird. Die linke Seite bildet den Input Layer, in dem VoxeLite Bewegungen, Druck und Mikrostrukturen an der Fingerkuppe registriert. In der Mitte befindet sich der AI Processing Layer, der diese Daten auswertet und semantisch versteht. Rechts entsteht im Output Layer die haptische Rückmeldung, die an Kontext, Nutzerintention und Umgebungsfaktoren angepasst ist.

- Input Layer – Die Grafik zeigt einen Finger mit einem transparenten VoxeLite-Haptikfilm. Das System erkennt Touch Input, registriert Microtexture Detection und erfasst über Motion Vector Capture die exakte Richtung und Geschwindigkeit der Bewegung. Diese Schicht ist gewissermaßen das „Sinnesorgan“ des Systems: Sie liefert Rohdaten darüber, was die Nutzerin oder der Nutzer gerade tut.

- AI Processing Layer – Im Zentrum steht ein hexagonales KI-Symbol, das die maschinelle Interpretation der Berührungen verdeutlicht. Hier befinden sich die Algorithmen zur Adaptive Feedback Engine sowie ein Machine Learning Model, das aus früheren Interaktionen lernt. Die KI erkennt Muster, Absichten und situative Änderungen und entscheidet, welches haptische Muster in der nächsten Millisekunde erzeugt werden sollte.

- Output Layer – Rechts visualisieren geschwungene Linien die Erzeugung dynamischer haptischer Signale. Der Bereich Dynamic Haptic Pattern Generation steht für die Synthese fühlbarer Oberflächen, während Context-Aware Texture Output zeigt, wie sich diese Muster je nach Anwendung verändern: mal rauer, mal glatter, mal klar konturiert oder subtil geführt. So entsteht ein Interface, das sich anfühlt, als reagiere es aktiv auf die Handbewegung.

Was diese drei Ebenen verbindet, ist ein kontinuierlicher Feedbackloop: Die Fingerbewegung erzeugt Daten, die KI interpretiert diese Daten und die Haptik reagiert in Echtzeit darauf. Genau diese Schleife macht aus VoxeLite nicht nur ein fühlbares Display, sondern ein adaptives Wahrnehmungssystem – eines, das Berührungen versteht und sie in veränderliche, semantisch bedeutsame Rückmeldungen übersetzt.

Im nächsten Abschnitt betrachten wir, wie sich diese Prinzipien weiterentwickeln könnten, wenn KI-gestützte Haptik in Simulation, Remote-Control oder industrielle Assistenzsysteme integriert wird. Dabei rückt die Frage in den Vordergrund, wie intelligente Berührungserlebnisse menschliche Fähigkeiten erweitern und neue Formen digitaler Zusammenarbeit ermöglichen.

Wenn digitale Haptik und KI zu einem lernenden System verschmelzen

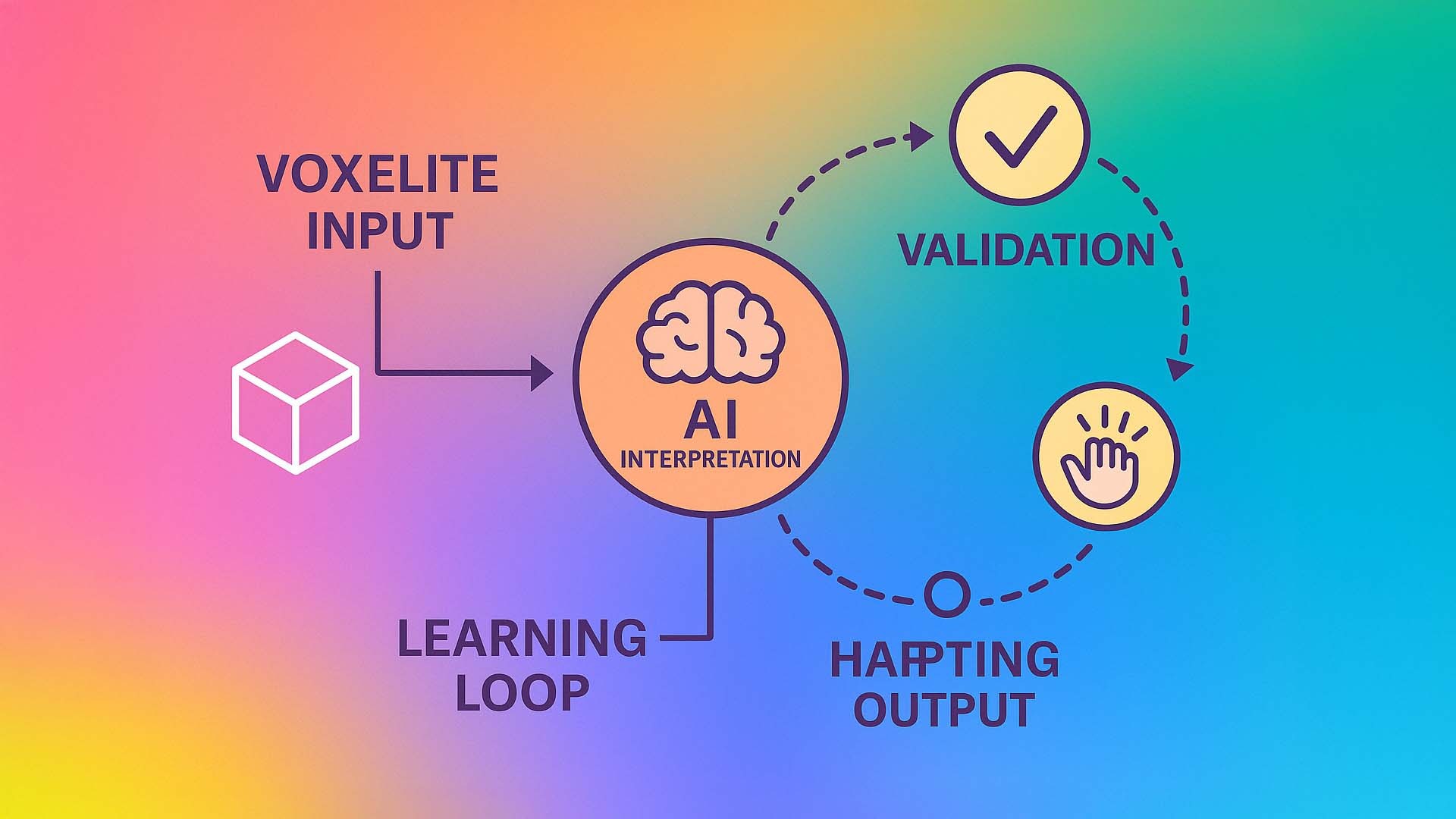

Damit VoxeLite nicht nur fühlbare Texturen erzeugt, sondern sich auch intelligent an Nutzende anpasst, braucht es ein System, das Berührungen nicht nur erzeugt, sondern aus ihnen lernt. Erst durch die Kombination aus haptischem Input, KI-Interpretation, dynamischer Rückmeldung und kontinuierlicher Validierung entsteht ein echter Lernkreislauf. Dieses Prinzip macht fühlbare Interfaces nicht nur präziser, sondern zunehmend intuitiv – vergleichbar mit Systemen, die den Nutzer im Laufe der Zeit „verstehen“ und ihre Rückmeldung verfeinern.

Dieser Ansatz ist zentral für die nächste Generation taktiler Technologien. Denn fühlbare Interfaces, die ihre Muster und Intensitäten auf Basis realer Interaktion anpassen, eröffnen ein völlig neues Spektrum an Anwendungen: von personalisierten UX-Erlebnissen bis hin zu intelligenten Assistenzsystemen, die situativ und kontextbezogen reagieren.

Haptischer KI-Lernkreislauf: VoxeLite-Input wird durch ein neuronales Interpretationsmodell verarbeitet, in fühlbares Feedback übersetzt und anschließend durch Nutzerreaktionen validiert. Die Illustration zeigt ein geschlossenes System aus Input, KI-Verarbeitung, Haptik-Output und kontinuierlicher Verbesserung.

Bild: © Ulrich Buckenlei | VISORIC GmbH 2025

Das Bild visualisiert die vier zentralen Ebenen, die ein lernfähiges haptisches Interface ausmachen. Links beginnt der Prozess mit dem VoxeLite-Input – dem digitalen Objekt oder Muster, das in eine fühlbare Struktur übersetzt werden soll. Die Illustration zeigt dies mit einem einfachen 3D-Würfel, der stellvertretend für jede Art digitaler Information steht.

Im Zentrum befindet sich der Kreis AI Interpretation, dargestellt mit einem ikonischen Gehirnsymbol. Hier entscheidet das System anhand von Sensordaten, Materialprofilen und Interaktionshistorien, wie die Textur berechnet werden muss: Soll sie rauer sein, weicher, stärker strukturiert, oder dynamisch auf Fingerbewegung reagieren? Dieser Schritt ist essenziell, denn hier entsteht die eigentliche „Intelligenz“ der Haptik.

Rechts im Diagramm folgt der Bereich Haptic Output, visualisiert durch ein stilisiertes Hand-Symbol. Hier wird die berechnete Information in reale fühlbare Mikrostrukturen übersetzt. Diese wirken wie ein physischer Ausdruck digitaler Inhalte und variieren je nach Kontext – von feinen Reibungsmustern bis hin zu präzisen Richtungssignalen.

Der obere Kreispunkt Validation, dargestellt durch ein Häkchen-Symbol, schließt den Lernprozess: Nutzerinnen und Nutzer geben unbewusst Rückmeldung über ihre Berührungen. Das System erkennt, welche Muster gut funktionieren und wo Anpassungen nötig sind. Diese Informationen fließen zurück in die Learning Loop am unteren Bildrand.

So entsteht ein adaptives System, in dem jede Berührung das Interface ein wenig besser macht. VoxeLite wird dadurch nicht nur eine statische Technologie, sondern ein lernendes Ökosystem, das sich an verschiedenste Anwendungen – von Gaming über Industrie bis hin zu Barrierefreiheit – dynamisch anpassen kann.

Wenn Forschung sichtbar wird: VoxeLite in Bewegung

Das folgende Video visualisiert, wie ultradünne haptische Interfaces auf Grundlage aktueller Forschungsergebnisse der Northwestern University fühlbare digitale Strukturen erzeugen. Es zeigt die Funktionslogik hinter VoxeLite: ein flexibles Mikroaktor-Feld, das sich wie eine zweite Haut an die Fingerkuppe legt und Berührung in Echtzeit modifiziert. Die Szenen demonstrieren, wie mikroskopische Reibungsmuster entstehen, wie Richtungsfeedback erzeugt wird und wie dynamische Texturen durch KI an Nutzende angepasst werden.

Obwohl VoxeLite selbst ein Forschungsprototyp ist, erlaubt das Video einen Blick darauf, wie sich digitale Haptik anfühlt, wenn Wissenschaft und Interface-Design zusammenkommen. Die Darstellung basiert auf öffentlich zugänglichen wissenschaftlichen Ergebnissen, wurde jedoch für diesen Artikel visuell neu interpretiert und dramaturgisch aufbereitet.

Demonstration des VoxeLite-Prinzips: Die Video-Visualisierung zeigt, wie mikroskopische Aktuatoren fühlbare digitale Texturen formen – von Richtungsimpulsen über dynamische Reibungsmuster bis hin zu rekonfigurierbaren Oberflächen.

Video: © Ulrich Buckenlei | VISORIC GmbH 2025 – inspiriert durch Forschung der Northwestern University

Im Video sind mehrere zentrale Elemente sichtbar: Zunächst die ultradünne haptische Schicht, die sich über die Fingerkuppe legt und die Grundlage für alle fühlbaren Effekte bildet. Darauf folgen mikroskopische Reibungsmuster, die sich je nach Bewegung, Druck und Interaktionskontext verändern. Die Visualisierung zeigt zudem, wie diese Muster durch KI analysiert und angepasst werden – ein Vorgang, der in der realen Forschung eine entscheidende Rolle spielt, wenn es darum geht, digitale Oberflächen präzise und dynamisch fühlbar zu machen.

Diese filmische Darstellung dient nicht nur als technische Veranschaulichung, sondern zeigt auch das Potenzial einer Technologie, die in Zukunft eine Brücke zwischen visuellen und taktilen digitalen Welten schlagen könnte. Sie macht sichtbar, wie die Kombination aus ultradünner Aktuatortechnik, physikalischer Reibungsmodulation und intelligenter Signalverarbeitung die Grundlage für eine neue Klasse haptischer Interfaces bildet.

Das VISORIC Expertenteam in München

Digitale Haptik macht erstmals fühlbar, was bisher nur gesehen wurde. VoxeLite zeigt, wie ultradünne Technologien reale Texturen spürbar machen und das Visoric Expertenteam unterstützt Unternehmen dabei, diese Innovation frühzeitig einzusetzen. Unsere Arbeit verbindet Forschung, Softwareentwicklung, Interface-Design und Prototyping zu Lösungen, die wissenschaftlich fundiert und gleichzeitig praktisch nutzbar sind.

Viele Organisationen stehen heute vor der Frage, wie sie neue Technologien wie digitale Haptik, Spatial Computing oder KI-gestützte Interaktion sinnvoll in ihre Produkte und Prozesse integrieren können.

Das VISORIC Expertenteam: Ulrich Buckenlei und Nataliya Daniltseva im Austausch über digitale Haptik, KI-gestützte Interfaces und zukünftige Interaktionsmodelle.

Quelle: VISORIC GmbH | München 2025

Genau hier begleitet Visoric mit Erfahrung, strategischer Klarheit und einem interdisziplinären Team, das komplexe Innovationsprojekte verständlich, planbar und realisierbar macht.

- Strategische Technologieberatung → Analyse von Chancen, Potenzialen und Anwendungsfeldern rund um digitale Haptik, Spatial Computing und KI.

- Konzeption und Prototyping → Entwicklung erster Proof-of-Concepts, UI-Logiken, Demonstratoren und experimenteller Interfaces, die technische Machbarkeit sichtbar machen.

- Softwareentwicklung → Umsetzung von Echtzeit-Interaktionssystemen, KI-Pipelines, Sensorfusion und maßgeschneiderten Visualisierungstools.

- Erweiterte Interface-Entwicklung → Gestaltung von 3D-Interfaces, haptischen Feedbacksystemen, digitalen Werkzeugen und immersiven Bedienkonzepten.

- End-to-End Projektbegleitung → Von der Forschungsanalyse über das Design bis hin zur produktionsreifen Implementierung in Industrie, Training, Service oder Simulation.

Wenn Sie darüber nachdenken, neue Formen digitaler Interaktion zu entwickeln, taktile Interfaces in Produkte zu integrieren oder die Möglichkeiten von KI und Spatial Computing strategisch für Ihr Unternehmen zu nutzen, unterstützen wir Sie gerne. Schon ein erstes Gespräch kann helfen, Potenziale sichtbar zu machen und den Weg zu klaren nächsten Schritten zu öffnen.

Kontaktpersonen:

Ulrich Buckenlei (Kreativdirektor)

Mobil: +49 152 53532871

E-Mail: ulrich.buckenlei@visoric.com

Nataliya Daniltseva (Projektleiterin)

Mobil: + 49 176 72805705

E-Mail: nataliya.daniltseva@visoric.com

Adresse:

VISORIC GmbH

Bayerstraße 13

D-80335 München