Bild: Virtuelle Bedienoberfläche im Wohnraum

Bild: © Ulrich Buckenlei | Visoric GmbH 2025

Unsichtbare Interaktionen werden greifbar

Die kommenden Generationen von Smartglasses und AR-Kontaktlinsen verändern grundlegend, wie wir mit digitalen Funktionen arbeiten. Statt Geräte zu bedienen, wird der Raum selbst zur Oberfläche. Digitale Inhalte erscheinen dort, wo wir sie brauchen, und passen sich unseren Bewegungen an. Diese neue Logik der Interaktion macht die Grenze zwischen physischer Welt und digitaler Erweiterung beinahe unsichtbar. Die Hand wird zum Werkzeug, und der dreidimensionale Raum zum Interface.

- Raum als Interface: Digitale Funktionen tauchen direkt im Umfeld des Nutzers auf.

- Natürliche Gesten: Bewegungen ersetzen Tasten, Wischen und Controller.

- Echtzeit-Feedback: Virtuelle Elemente reagieren unmittelbar auf feine Mikrobewegungen.

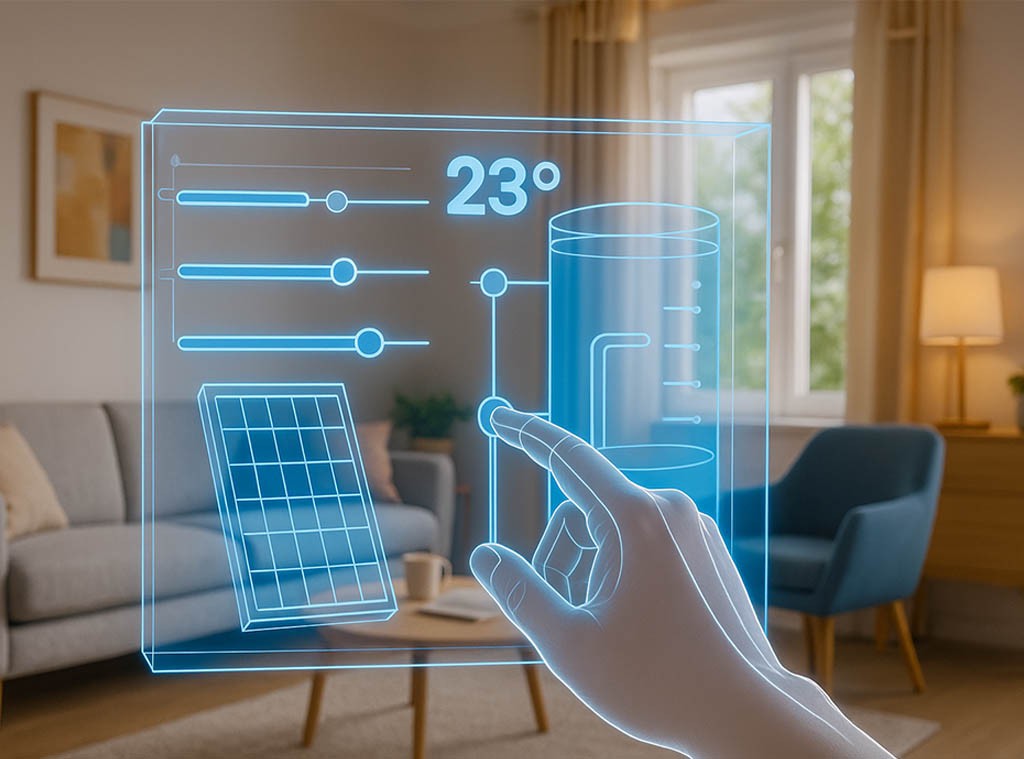

Bild: AR-Bedienoberfläche für Haustechnik, durch Smartglasses

Bild: © Ulrich Buckenlei | Visoric GmbH 2025

Der Ansatz eröffnet eine völlig neue Form von Effizienz. Statt umständlich Apps zu öffnen, erscheint ein virtuelles Panel genau dort, wo die Funktion entsteht – etwa eine Heizungssteuerung direkt im Wohnzimmer, während das reale System im Keller steht. Der Nutzer bewegt die Hand durch die Luft, und ein fein animiertes Interface reagiert auf ihre Position. Einstellungen ändern sich durch subtile Gesten, ohne dass ein Gerät berührt werden muss.

Solche Konzepte zeigen, wie nahtlos digitale Informationen künftig in unseren Alltag eingewoben sein werden. Gleichzeitig entsteht eine intuitive Arbeitslogik, die nicht mehr zwischen „digital“ und „real“ unterscheidet. Die Umgebung wird zum intelligenten Begleiter, der Funktionen sichtbar macht, sobald sie relevant werden. Im nächsten Abschnitt widmen wir uns der Frage, wie Unternehmen diese neuen räumlichen Interaktionen schon heute für Design, Engineering und Produktentwicklung einsetzen.

Unsichtbare Interaktionen werden sichtbar gemacht

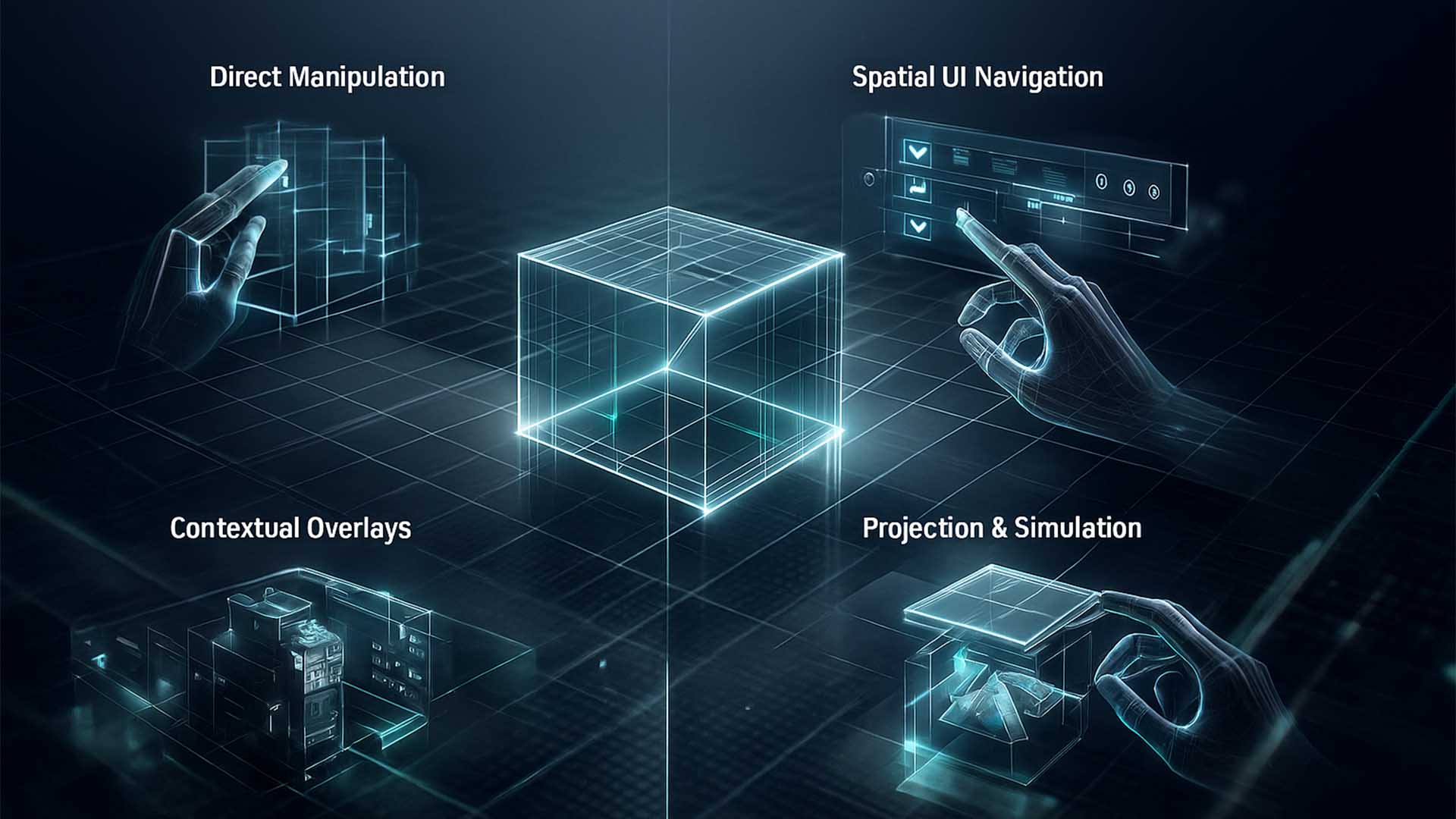

Die Steuerung von digitalen Inhalten im Raum beginnt immer mit einer klaren Frage. Wie erkennt ein System eigentlich, was wir tun wollen, bevor wir überhaupt etwas berühren. Moderne AR-Interfaces greifen dafür auf drei grundlegende Arten der Interaktion zurück, die zusammen eine intuitive, natürliche und körpernahe Bedienlogik formen. Sichtbar wird das erst, wenn wir die unsichtbaren Ebenen der virtuellen und realen Welt übereinanderlegen und präzise analysieren, wie unsere Hände, unsere Blickrichtung und unsere Bewegungen miteinander verbunden sind.

Das neu visualisierte Schaubild zeigt diese Logiken in einer reduzierten und dennoch hochpräzisen Übersicht. Vier Interaktionspfade werden dargestellt und jeder Pfad steht für einen elementaren Baustein zukünftiger AR-Erfahrungen. Die grafische Darstellung arbeitet mit klaren Linien, leuchtenden Konturen und einem technischen Metallic-Farbklang, der den modernen Charakter der Technologie unterstreicht. Sie hilft, die abstrakten Prinzipien auf einen Blick zu erfassen und bildet die Grundlage für alle späteren Design- und Entwicklungsentscheidungen.

- Hand Tracking → Bewegungen der Finger und Handflächen werden in Millisekunden analysiert

- Gesture Commands → definierte Gesten lösen systemische Aktionen aus

- Spatial Mapping → der Raum wird in Echtzeit kartiert und digital interpretierbar

- Object Anchoring → virtuelle Objekte bleiben stabil im Raum verankert

Grundlogiken räumlicher Interaktion: Die Grafik zeigt vier typische Interaktionspfade, die AR-Systeme nutzen, um menschliche Absichten präzise zu erfassen.

Bild: © Ulrich Buckenlei | Visoric GmbH 2025

Die Abbildung macht sichtbar, wie diese Interaktionsarten zusammenarbeiten. Hand Tracking und Gestensteuerung bilden die körperliche Ebene, während Spatial Mapping und Anchor-Techniken die räumliche Stabilität liefern. Diese vier Mechanismen schaffen gemeinsam eine Bedienwelt, die sich anfühlt, als könne man digitale Elemente so selbstverständlich bewegen wie reale Gegenstände. In der Praxis werden sie zur Grundlage einer neuen Arbeitslogik, die zunehmend über klassische Bildschirme hinauswächst und sich direkt in unsere Umgebung integriert.

Dimensionale Navigation im Raum

Die Navigation in zukünftigen Augmented-Reality-Umgebungen wird nicht länger von flachen Menüs oder zweidimensionalen Oberflächen geprägt sein. Stattdessen bewegt sich die Interaktion in volumetrischen Strukturen, die sich wie greifbare Informationsräume anfühlen. Nutzerinnen und Nutzer öffnen Inhalte nicht mehr durch Klicken, sondern durch gezielte Gesten, räumliche Bewegung und intuitive Nähe zu digitalen Objekten. Die Interaktion wird dadurch körperlicher, natürlicher und zugleich schneller, da die räumliche Position selbst zu einem aktiven Steuerungsparameter wird.

Im Alltag führt das zu ganz neuen Handlungsabläufen. Inhalte ordnen sich automatisch um die reale Umgebung herum an, schweben in verschiedenen Tiefenebenen und reagieren auf Blickrichtung und Körperposition. Dadurch entsteht eine Form des Arbeitens, die weniger wie der Umgang mit einem Computer wirkt und mehr wie eine Erweiterung der eigenen Wahrnehmung. Indem digitale und physische Ebenen miteinander verschmelzen, entsteht eine Art mentaler Bewegungsraum, der produktive Entscheidungen erleichtert und die Informationsaufnahme beschleunigt.

- Räumliche Tiefe als Interface → Informationen erscheinen auf unterschiedlichen Distanzen

- Bewegung als Steuerung → Position, Nähe und Blickrichtung beeinflussen Inhalte

- Adaptive Informationsarchitektur → Der Raum strukturiert sich dynamisch anhand der Aufgabe

Mehrdimensionale Navigation: Digitale HUD-Ebenen gestaffelt in der Tiefe eines realen Raums, verbunden durch farbcodierte Linien für Fokus, Feedback und Auswahl.

Bild: © Ulrich Buckenlei | Visoric GmbH 2025

Die Visualisierung zeigt, wie sich digitale Informationen in mehreren Tiefenschichten strukturieren können. Im Vordergrund erscheint ein klarer Fokuslayer, der präzise Gesten erkennt und direkte Interaktion erlaubt. Dahinter liegen halbtransparente Informationszonen, die ergänzende Daten anzeigen, ohne das Blickfeld zu überladen. Farbige Linien markieren logische Zusammenhänge zwischen Ebenen und zeigen, wie Entscheidungen oder Gesten Inhalte dynamisch verschieben. Die Szene macht sichtbar, wie sich räumliche Interaktion in AR anfühlt: lebendig, intuitiv und eng an die tatsächliche Umgebung angepasst.

Adaptive Interfaces für unterschiedliche Umgebungen

Die nächste Generation virtueller Arbeitsumgebungen erkennt nicht nur Hände, Gesten und Absichten, sondern versteht auch den Kontext des Raums. Ob Büro, Homeoffice oder industrielle Halle, jedes Umfeld besitzt eigene Akustik, Lichtverhältnisse und Bewegungsmuster. Adaptive Interfaces beziehen diese Signale in Echtzeit ein und platzieren Bedienelemente dort, wo sie am wenigsten stören und am besten erreichbar sind.

Gleichzeitig verändern sich diese Interface Ebenen dynamisch mit der Tätigkeit. Wenn Menschen sich bewegen, wechseln Arbeitsmodi oder neue Informationen relevant werden, passen sich Position, Größe und Detailtiefe der virtuellen Elemente an. So entsteht eine Arbeitslogik, in der der digitale Layer nicht mehr wie eine zusätzliche Ebene wirkt, sondern wie eine intelligente Erweiterung des realen Raums.

- Kontextbewusstsein → Interfaces reagieren auf Raum, Licht und Bewegung

- Dynamische Platzierung → Bedienelemente wandern dorthin, wo sie intuitiv erreichbar sind

- Situative Detailtiefe → Anzeigen passen Informationsmenge an Fokus und Aufgabe an

Adaptive virtuelle Bedienelemente im dreidimensionalen Raum

Bild © Ulrich Buckenlei | Visoric GmbH 2025

Die Visualisierung zeigt ein frei schwebendes Interface, das sich an den Raum und die Hand des Nutzers anpasst. Halbtransparente Schaltflächen und Regler legen sich sauber in die Tiefe des Raums, ohne reale Objekte zu verdecken. Die Konturen der Hand sind als leuchtende Linie markiert und machen sichtbar, wie sich reale Bewegung und virtueller Layer präzise ineinander greifen. Damit wird erfahrbar, wie adaptive Interfaces den Übergang zwischen physischer Umgebung und digitaler Steuerlogik nahezu unsichtbar machen.

Im folgenden Abschnitt rücken wir näher an den praktischen Alltag heran und betrachten, wie solche kontextsensitiven Interaktionen konkrete Arbeitsprozesse vereinfachen und beschleunigen können.

Wie KI unsichtbare Interaktion möglich macht

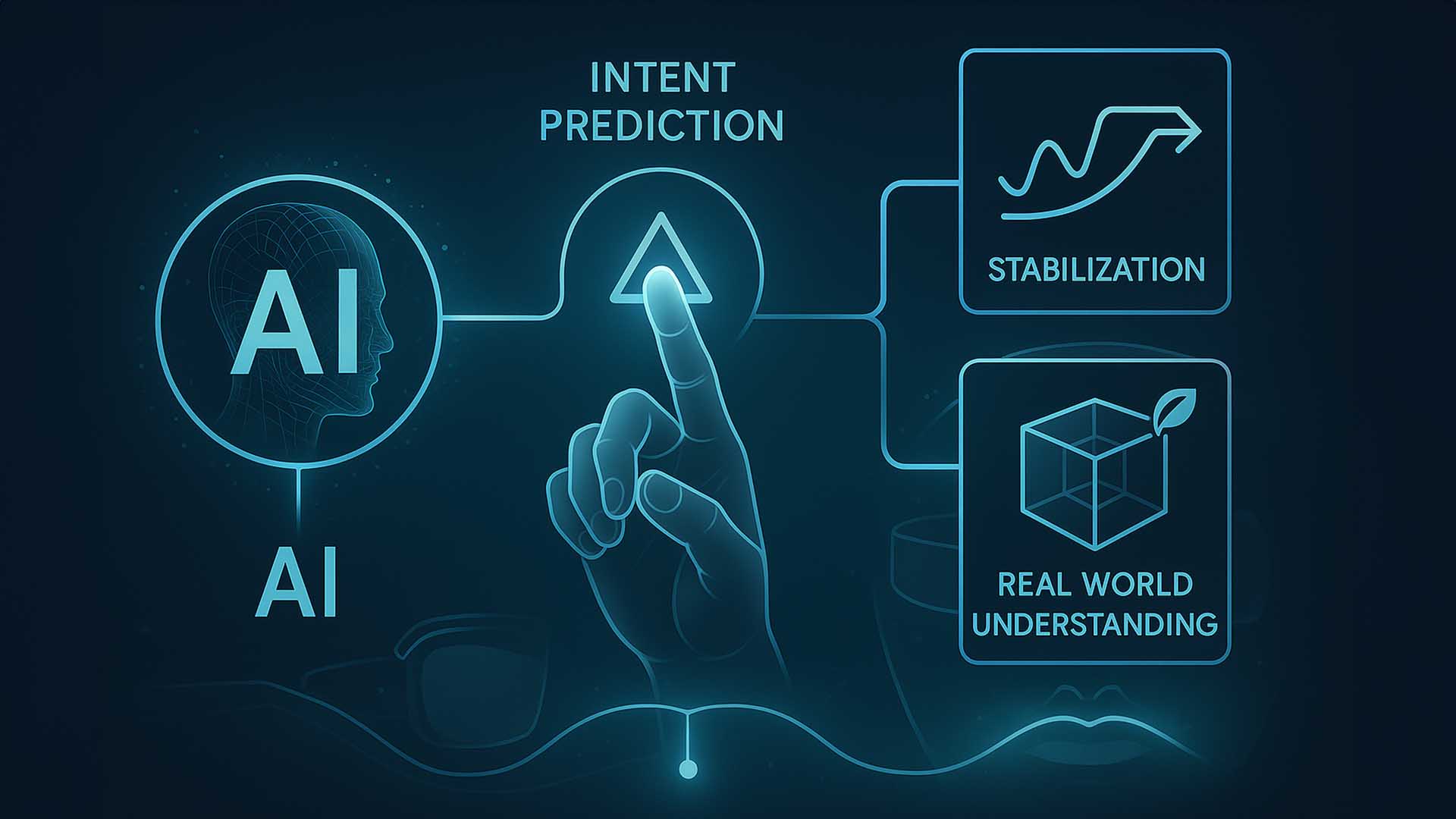

Unsichtbare Berührung im virtuellen Raum funktioniert nicht allein durch gute Sensorik. Die wahre Intelligenz entsteht erst, wenn KI die unvollständigen, schnellen oder komplexen Bewegungen der Hand in einen präzisen Steuerbefehl übersetzt. Moderne Systeme erkennen Muster in Mikrogesten, füllen fehlende Datenlücken und antizipieren Absichten der Nutzerinnen und Nutzer. Dadurch fühlt sich Interaktion nicht wie ein technischer Vorgang an, sondern wie ein natürlicher Bewegungsfluss. Die folgende Visualisierung zeigt, wie mehrere KI-Schichten zusammenarbeiten, um aus realen Handbewegungen eine exakt berechnete, räumlich stabile und kontextbezogene Interaktion zu erzeugen.

- Erkennung der Handbewegung → KI interpretiert Gesten und Bewegungsabsichten in Echtzeit

- Analyse des Raums → Systeme berechnen Tiefe, Objekte und Interaktionszonen fortlaufend

- Adaptive Steuerung → Virtuelle Elemente passen sich dynamisch an den Kontext und die Handlung an

Visualisierung der KI-Schichten: Sensorik, Gesture Interpretation, Spatial Mapping und Adaptive Output wirken zusammen, um die virtuelle Interaktion präzise und natürlich erscheinen zu lassen.

Bild: © Ulrich Buckenlei | Visoric GmbH 2025

Die Abbildung zeigt die vier zentralen Ebenen, die moderne Invisible Touch Interaktionen ermöglichen. Links beginnt der Prozess mit der Erfassung der realen Handbewegung. Die KI interpretiert diese Daten in der zweiten Ebene und erkennt Absichten, Muster und Mikrogesten. Die dritte Ebene verbindet die Geste mit dem räumlichen Kontext und berechnet, wo sich virtuelle Objekte befinden und wie sie reagieren sollen. In der vierten Ebene wird das passende Ergebnis erzeugt. Dadurch fühlt sich der virtuelle Raum stabil, logisch und intuitiv an, auch wenn die reale Bewegung unpräzise, zu schnell oder unvollständig ist. KI wird damit zum unsichtbaren Motor, der die natürliche Interaktion im digitalen 3D Raum erst möglich macht.

Unsichtbare Interaktion im Alltag: Wie sich der virtuelle Raum nahtlos in unsere Realität einfügt

Im sechsten Abschnitt richten wir den Blick auf das große Ganze. Nachdem zuvor Gestensteuerung, Interaktionsmodelle, räumliche Präzision und KI-Verarbeitung im Detail betrachtet wurden, zeigt dieses Kapitel, wie all diese Technologien zu einem einheitlichen Erfahrungsraum verschmelzen. Entscheidend ist die Erkenntnis, dass unsichtbare Interaktion keine Zukunftsvision mehr ist. Sie entsteht dort, wo digitale Überlagerungen, intuitive Gesten und KI-Assistenten zusammenkommen und unseren Alltag sinnvoll erweitern.

Das hier eingesetzte Visual macht deutlich, wie sich Nutzerinnen und Nutzer künftig durch rein intuitive Mikrogesten durch virtuelle Elemente bewegen. Der reale Raum bleibt vollständig sichtbar, während digitale Schichten wie selbstverständlich darüberliegen. Die Hand agiert als natürliche Schnittstelle und wird von einem semitransparenten Overlay begleitet, das Präzision und Kontext vermittelt. Die dargestellte Interaktion zeigt, wie digitale und reale Informationen nahtlos verschmelzen.

- Nahtlose Verschmelzung → Virtuelle Informationen liegen direkt auf der realen Umgebung

- Intuitive Steuerung → Mikrogesten dienen als natürliche Eingabe

- Alltagstaugliche Anwendung → Informationen, Parameter und Systeme werden unmittelbar zugänglich

Unsichtbare Interaktion: Eine reale Hand steuert ein digitales 3D-Interface, das im Raum schwebt.

Bild: © Ulrich Buckenlei | Visoric GmbH 2025

Das Bild zeigt eine Hand, die mit einem schwebenden holografischen 3D-Würfel interagiert, der einen AI-Kern beinhaltet. Die semitransparenten Linien der Struktur verdeutlichen gleichzeitig Tiefe und Präzision. Der Hintergrund bleibt ein realer Wohnraum, jedoch abgedunkelt, sodass die digitale Überlagerung in den Fokus rückt. Die Szene macht sichtbar, wie eine intuitive Bewegung der Finger ausreicht, um parametrisierte Objekte, Einstellungen oder gesamte Systeme zu steuern. Damit wird klar, wie Invisible Touch in alltäglichen Räumen funktionieren wird und wie selbstverständlich diese Interaktion wirken kann.

Video – Interaktion im dreidimensionalen Raum in Bewegung

Der folgende Videomitschnitt zeigt ein frühes, aber eindrucksvolles Funktionsmodell räumlicher Interaktion. Die Aufnahme demonstriert, wie digitale Strukturen in Echtzeit gegriffen, gedreht, skaliert und neu organisiert werden können – allein durch natürliche Handbewegungen. Jede Geste wirkt unmittelbar im virtuellen Raum und lässt den Prozess intuitiv und präzise erscheinen.

Das Besondere an dieser Demonstration ist die Klarheit, mit der sich digitale Elemente anfühlen: Sie schweben nicht nur vor dem Nutzer, sondern reagieren auf dieselben motorischen Reflexe, die wir aus der physischen Welt kennen. Damit entsteht ein Interface, das nicht wie ein Werkzeug wirkt, sondern wie eine natürliche Erweiterung unserer Hände.

Spatial Creation Prototype – Fully gesture-driven manipulation of digital structures

Video: Prototype by Oleg Frolov · Commentary by Ulrich Buckenlei · Fair use for analytical purpose

Im Video lässt sich gut erkennen, wie die digitale Struktur in Echtzeit auf jede Drehung, Verschiebung oder Skalierung reagiert. Einzelne Module werden verformt, verschoben oder neu zusammengesetzt, ohne dass klassische Bedienelemente sichtbar sind. Alles entsteht direkt im dreidimensionalen Raum – dort, wo später auch komplexe Modelle, Interfaces oder Industrieprozesse gestaltet werden könnten.

Diese Demonstration verdeutlicht, wie sich Kreativität verändern wird, sobald Interaktion vollständig räumlich funktioniert. Gestaltung wird nicht mehr am Bildschirm ausgeführt, sondern mitten im Raum. Und die Kombination aus präzisen Gesten und lernfähiger KI bildet die Grundlage einer völlig neuen Generation digitaler Werkzeuge.

Das Visoric Experten Team in München

Die hier vorgestellten Konzepte entstehen in einem Umfeld, in dem Forschung, Kreativität und technologische Präzision konsequent zusammenfinden. Unser Team in München arbeitet seit vielen Jahren daran, die Möglichkeiten räumlicher Interaktion weiterzuentwickeln und für Unternehmen nutzbar zu machen. Wir untersuchen, wie Menschen künftig mit digitalen Welten umgehen und wie intelligente Systeme diese Interaktionen nahtlos unterstützen können.

Unsere Expertise umfasst AI-basierte Interaktionsmodelle, Spatial Computing Workflows, volumetrische User Interfaces und immersive Designprozesse. In enger Zusammenarbeit mit Forschungspartnern und global führenden Unternehmen entstehen Lösungen, die technische Tiefe mit praktischer Anwendbarkeit verbinden. Ziel ist es immer, komplexe Zukunftstechnologien so aufzubereiten, dass sie bereits heute in realen Projekten echten Nutzen schaffen.

- Strategie und Konzept → Entwicklung zukunftsfähiger Spatial Interaction Modelle

- Design und Content → Präzise 3D Visualisierungen und interaktive Spatial Workflows

- Technische Umsetzung → AI gestützte Interaktionen, Motion Intelligence und XR Systeme

Das Visoric Experten Team: Ulrich Buckenlei und Nataliya Daniltseva

Quelle: Visoric GmbH | München 2025

Die gezeigte Aufnahme steht exemplarisch für den Ansatz unseres Teams. Technologie wird nicht nur angewendet, sondern von Grund auf verstanden und weiterentwickelt. Der Fokus liegt darauf, digitale Werkzeuge so einzusetzen, dass sie Menschen unterstützen, kreative Prozesse vereinfachen und technische Anforderungen zuverlässig erfüllen. Viele Projekte beginnen mit ersten Ideen oder visuellen Skizzen. Daraus entsteht ein klar strukturierter Workflow, der zu beeindruckenden Ergebnissen führt, die intuitiv funktionieren und technisch belastbar sind.

Wenn Sie darüber nachdenken, eigene Konzepte für Spatial Interaction, AI gestützte Workflows oder immersive Produktentwicklung zu entwickeln, begleiten wir Sie gerne. Ein erstes Gespräch reicht oft aus, um neue Potenziale sichtbar zu machen und konkrete nächste Schritte zu definieren. Ob für Prototypen, Innovationsprojekte oder langfristige digitale Strategien, unser Team steht bereit.

Kontaktpersonen:

Ulrich Buckenlei (Kreativdirektor)

Mobil: +49 152 53532871

E-Mail: ulrich.buckenlei@visoric.com

Nataliya Daniltseva (Projektleiterin)

Mobil: + 49 176 72805705

E-Mail: nataliya.daniltseva@visoric.com

Adresse:

VISORIC GmbH

Bayerstraße 13

D-80335 München